斯坦福曼寧教授主題演講

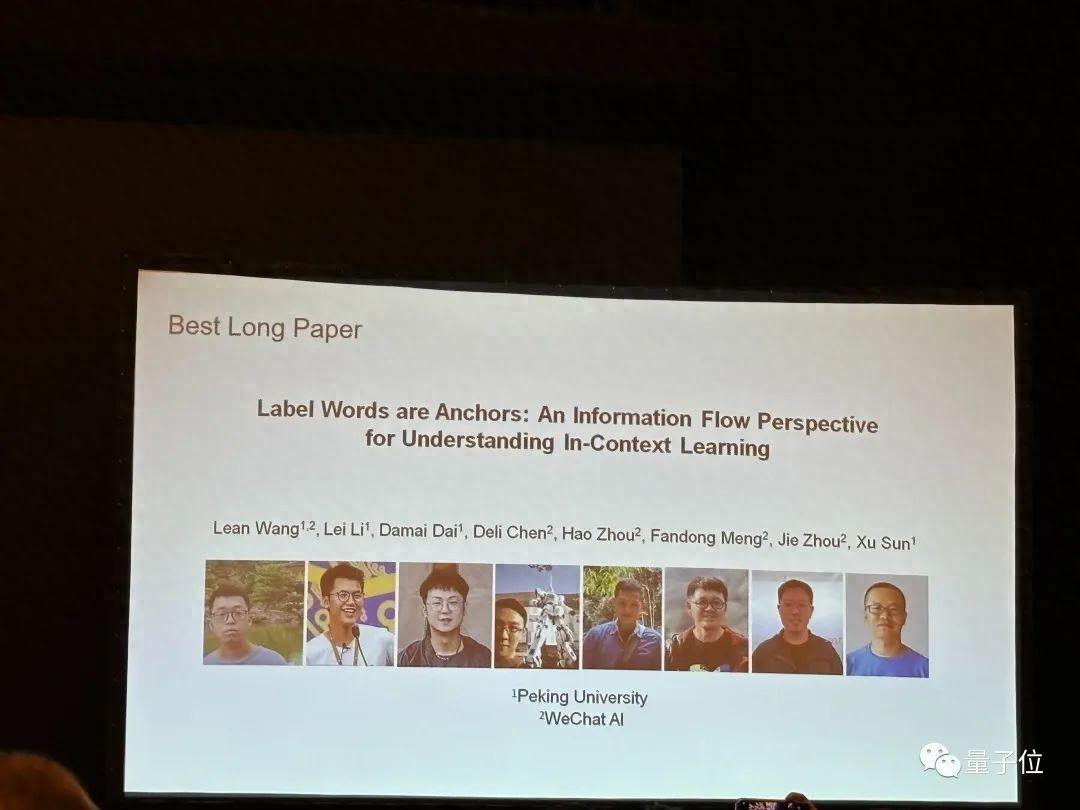

EMNLP頂會落下帷幕,各種獎項悉數頒出。

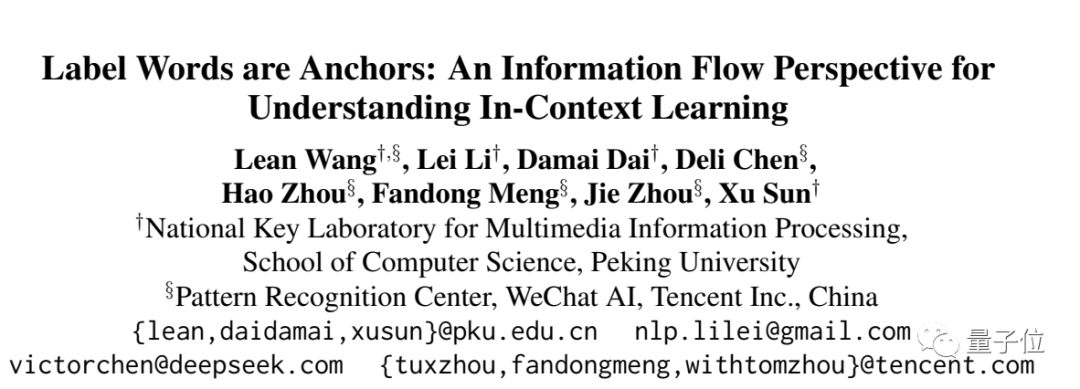

最佳長論文獎被北大微信AI團隊收入囊中,由北大孫栩老師和微信周杰、孟凡東合作指導。

他們發現了大模型中關鍵能力——上下文學習背後的工作機制。

通過理解這一機制,還提出一系列方法來提高其性能。

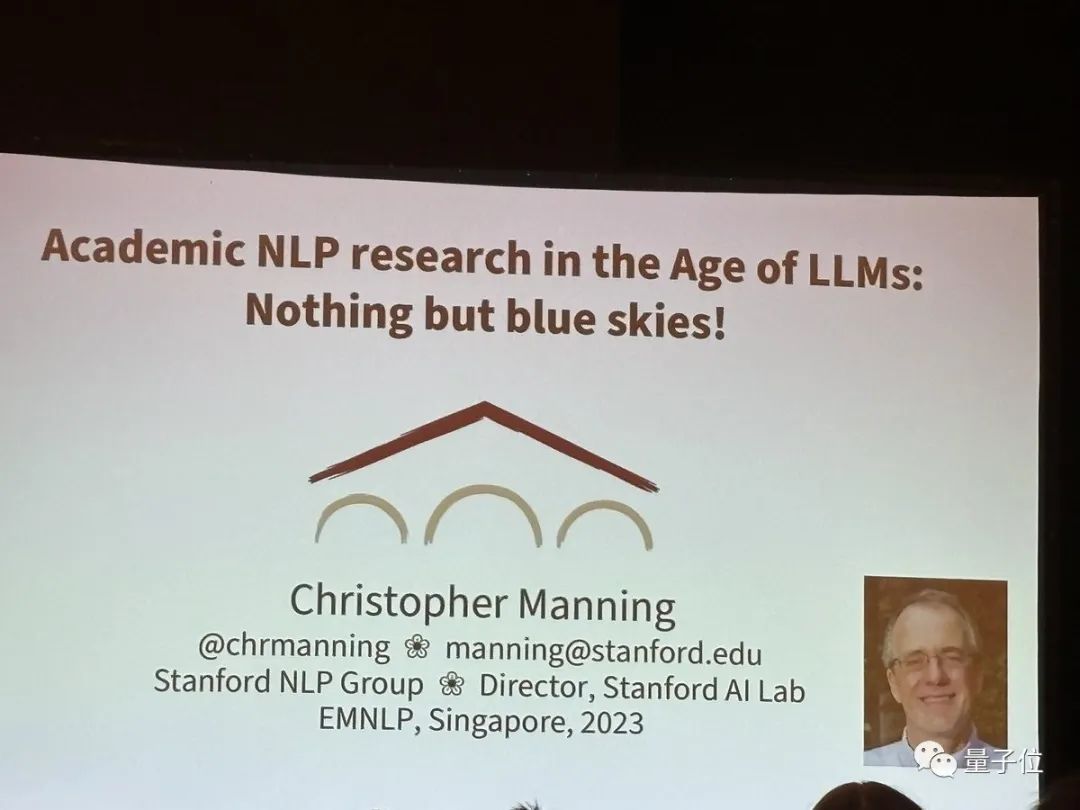

除此之外,斯坦福Christopher Manning教授做了最後的主題演講,告訴那些正在爲大模型而感到焦慮的NLP博士生們,還有很多有意義的方向可以做。

EMNLP最佳長論文

上下文學習(in-context learning, ICL)是大語言模型的一個重要能力,通過提供少量示範示例,讓模型學會執行各種下游任務,而無需更新參數。

目前ICL內在工作機制仍尚無定論,但缺乏對ICL過程的理解會限制能力進一步提升。

基於這一背景,北大&微信AI團隊首次從信息流這一角度來探索。此前相關分析研究主要從輸入作用和梯度角度進行分析。

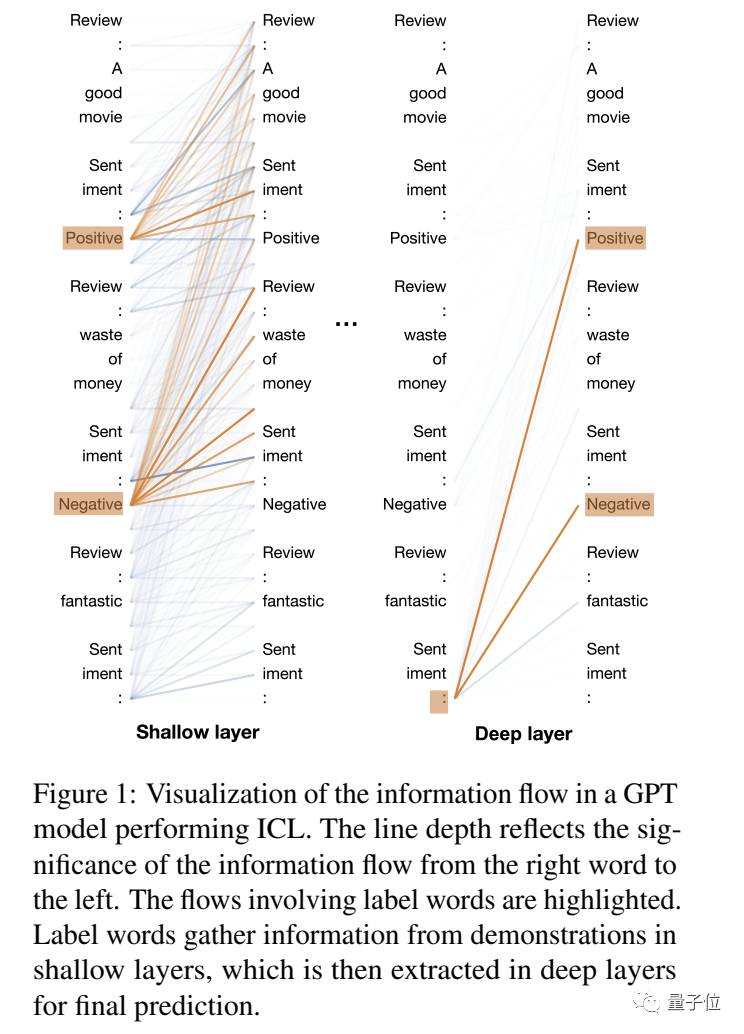

首先,他們利用執行ICL的GPT模型,將標籤詞之間的注意力互動模式(即信息流)可視化。

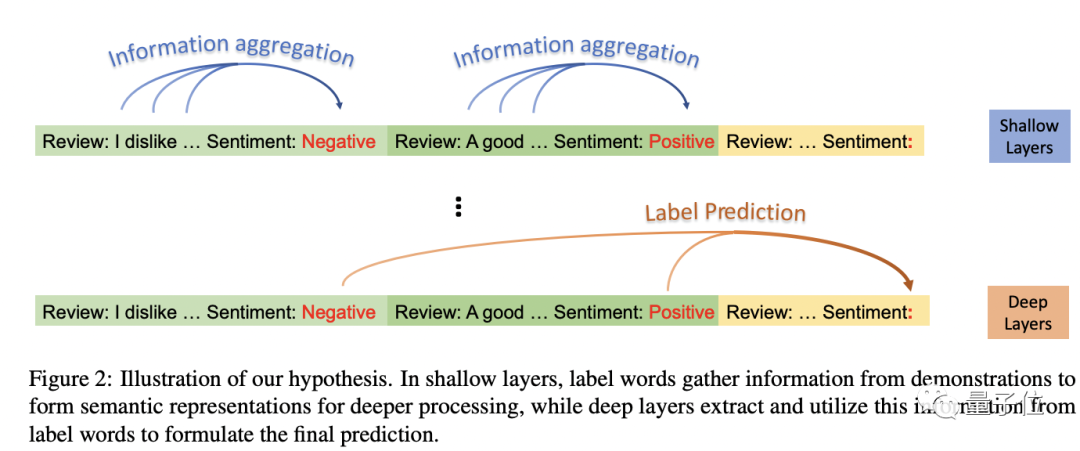

“淺層”或“第一層”指的是離輸入較近的層,而“深層”或“最後一層”指的是離輸出較近的層。

初步觀察表明,標籤詞在淺層聚合信息,並在深層分發信息。

爲了清晰描述這一現象,研究人員提出了一個假設:

標籤詞是ICL中聚合和分發信息的錨點。(Label Words are Anchors)

具體而言:

- 在淺層,標籤詞收集演示信息,爲深層形成語義表徵。

- 在深層,模型從標籤詞中提取信息,形成最終預測。

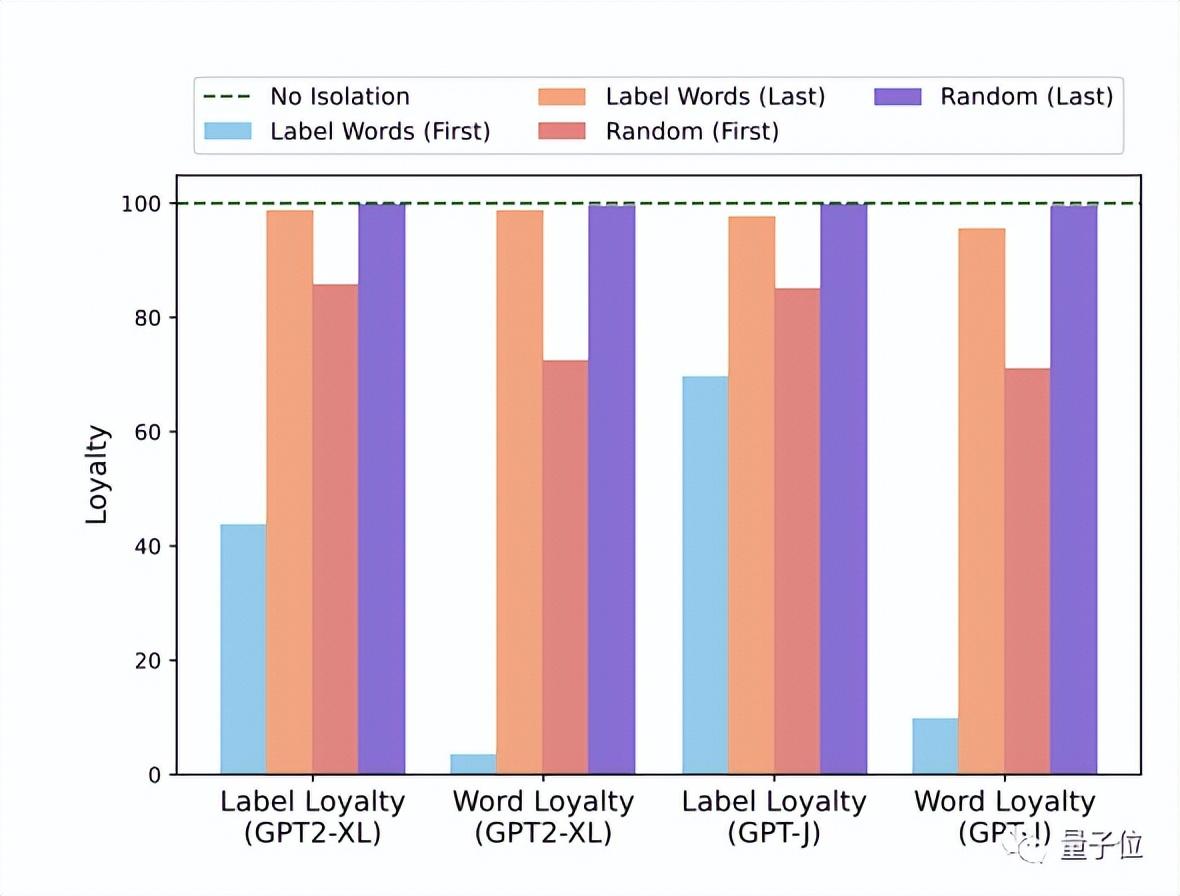

爲了驗證這一假設,他們設計了兩個實驗,使用GPT2-XL和GPT-J在多個文本分類基準中驗證:

1、阻斷某些層中標籤詞的信息聚合路徑,結果發現在淺層隔離會顯著影響性能,這表明標籤詞在淺層中的前向傳播過程中收集了有用的信息。

2、目標位置標籤詞的注意力分佈與模型最終預測結果的關係,結果表明兩者之間存在很強的正相關性。

基於這樣的發現,他們提出了三種改進ICL的方法:一種重新加權方法來提高ICL性能;一種上下文壓縮技術來加速推理以及一種用於診斷 GPT2-XL 中 ICL 錯誤的分析框架。

其他情況

除此之外,最佳短論文、最佳主題論文、最佳論文Demo等各種獎項也全都揭曉。

其中

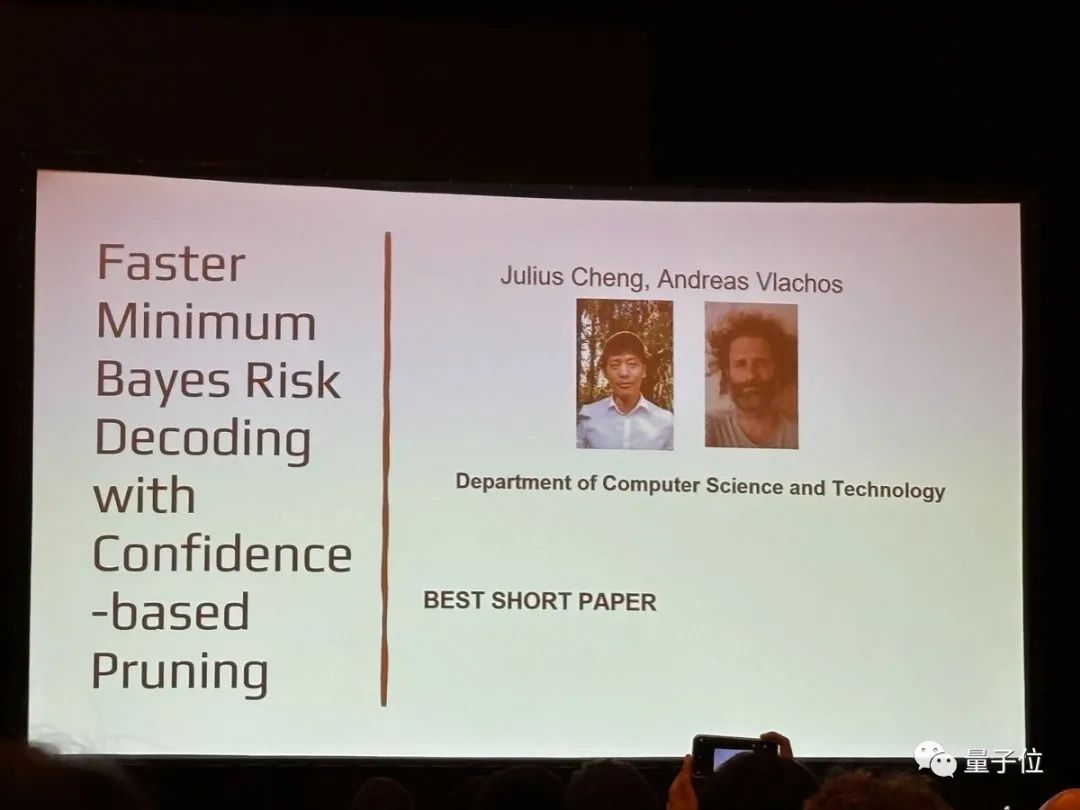

基於置信度的剪枝更快的最小貝葉斯風險解碼

,花落劍橋大學計算機系研究團隊,一作是華人博士生Julius Cheng。

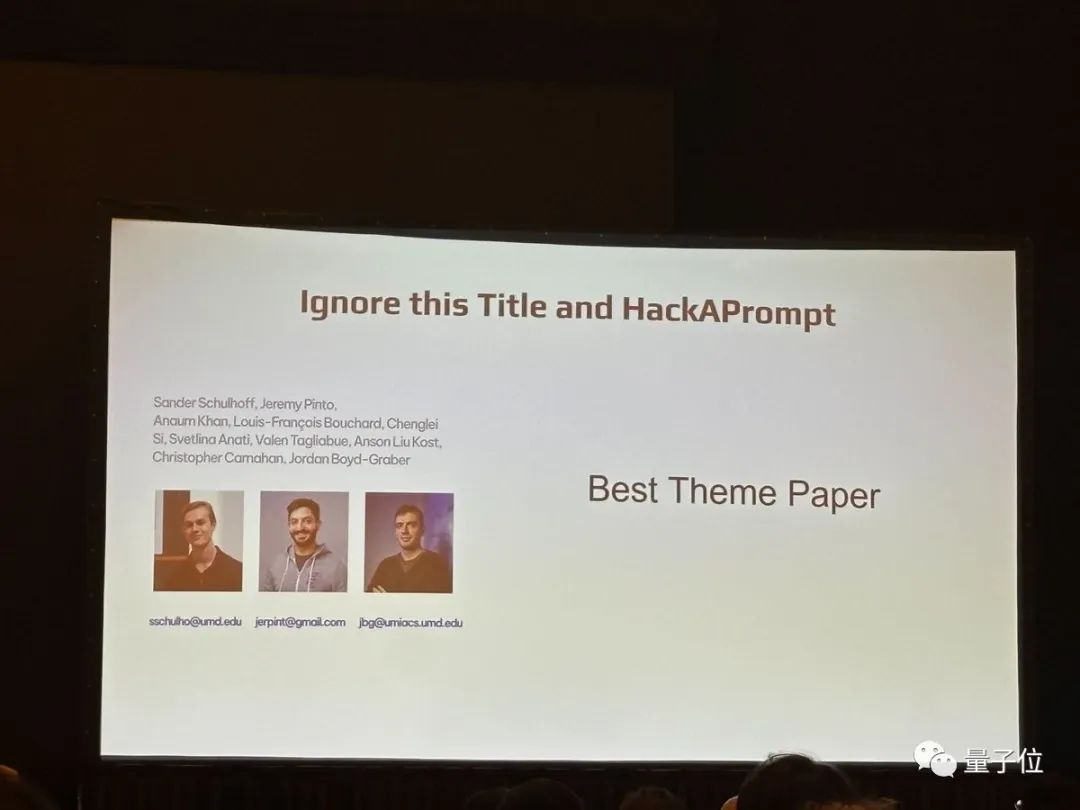

忽略這個標題和HackAPrompt:通過全球即時黑客競賽暴露llm的系統性漏洞

(忽略此標題and HackAPrompt:通過全球黑客大賽揭露大模型的系統漏洞)

還有最佳論文Demo則是由艾倫AI研究所、MIT、UC伯克利、華盛頓大學等研究團隊獲得,他們提出了PaperMage,處理、表示和操作視覺豐富的科學文檔統一工具包。

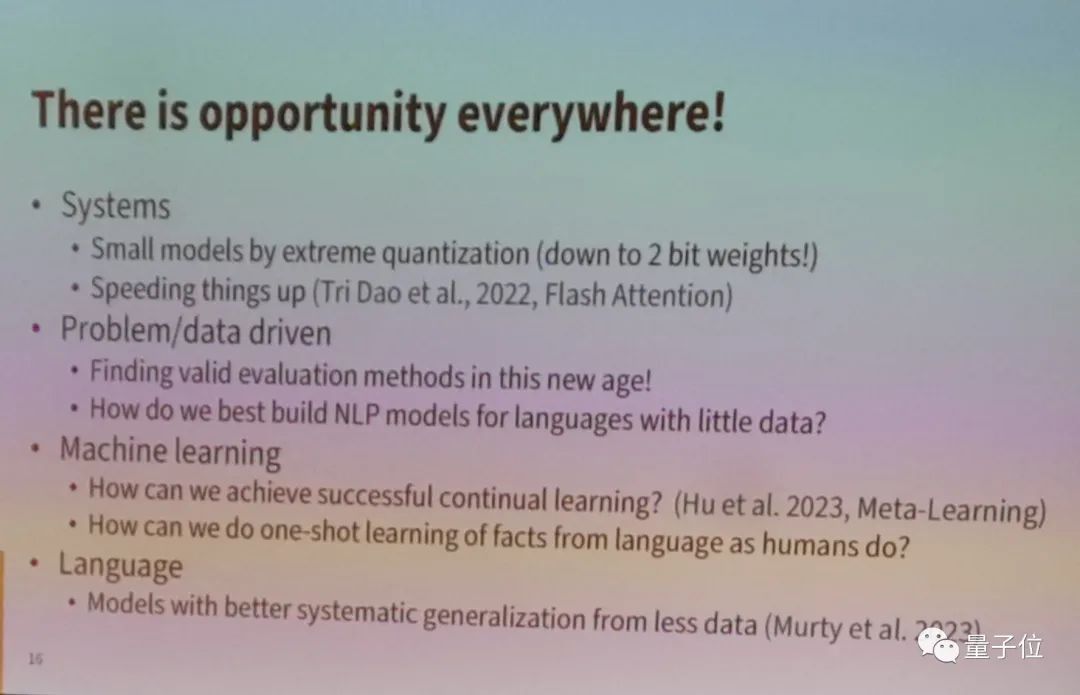

值得一提的是,斯坦福Christopher Manning教授完成了EMNLP最後一場主題演講是,現場座無虛席。

主題是大模型時代下NLP的學術研究:Nothing but blue skies!

他告訴正面臨「生存危機」的NLP博士生們:

航空學的學生不會爲了他們的博士論文而製造波音飛機。他們做更小的模型,但仍然做出有意義的貢獻。我們也有很多這樣的機會。

(航空專業的學生不會爲他們的博士論文建造波音飛機。他們製造較小的模型,但仍然做出了有意義的貢獻。我們也有很多這樣的機會。)

隨後他又詳細地介紹了下有哪些機會可研究之,主要包括系統、待解決問題/數據驅動、機器學習、語言等層面。

- 系統:

極端量化的小模型;加速。 - 問題/數據驅動:

尋找有效的評估方法;如何用哪個很少語言數據來建立NLP模型。 - 機器學習:

如何實現持續學習;如何跟人類一樣能從少樣本事實中學習。 - 語言

:較少數據獲得系統概括性更強的模型。

參考鏈接:

[1]https://twitter.com/emnlpmeeting/status/1733758625792016597

[2]https://x.com/annargrs/status/1733732418992160854?s=20

如若转载,请注明出处:https://www.tuio.cc/1495.html