帶動MoE再次成爲開源社區最火議題

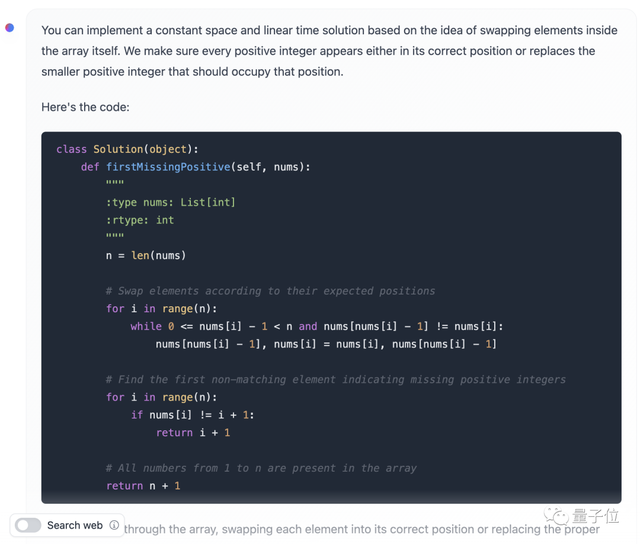

但隨着我們繼續提問,Mixtral的回答一不小心暴露了自己可能專門針對LeetCode做過訓練,而且還是中文版LC。

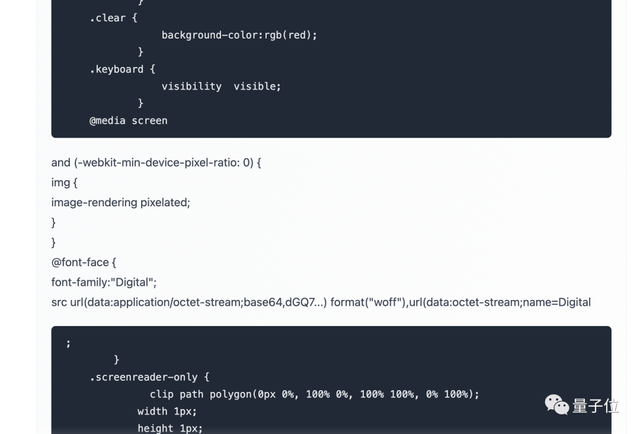

爲了更加真實地展示Mixtral的代碼能力,我們轉而讓它編寫實用程序——用JS寫一個Web版計算器。

經過幾輪調整之後,雖然按鈕的佈局有些奇怪,但基本的四則運算已經可以完成了。

此外我們會發現,如果在同一個對話窗口中不斷補充新的要求,Mixtral的表現可能會有所下降,出現代碼格式混亂等問題,開啓新一輪對話後則會恢復正常。

除了API和在線版本,Mistral AI還提供了模型下載服務,可以用上的磁力鏈接或通過Hugging Face下載之後在本地部署。

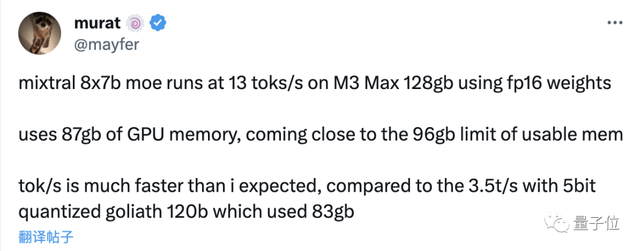

在上,已經有不少網友在自己的設備上跑起了Mixtral,還給出了性能數據。

在128GB內存的蘋果M3 Max設備上,使用16位浮點精度運行Mixtral時消耗了87GB顯存,每秒可以跑13個token。

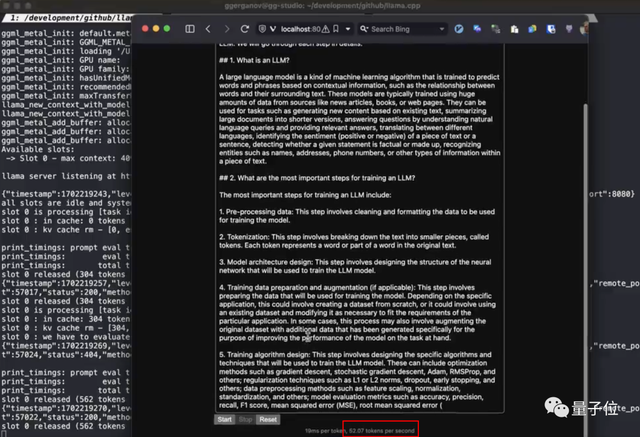

同時也有網友在M2 Ultra上通過llama.cpp跑出了每秒52token的速度。

看到這裏,你會給Mistral AI的模型實力打幾分?

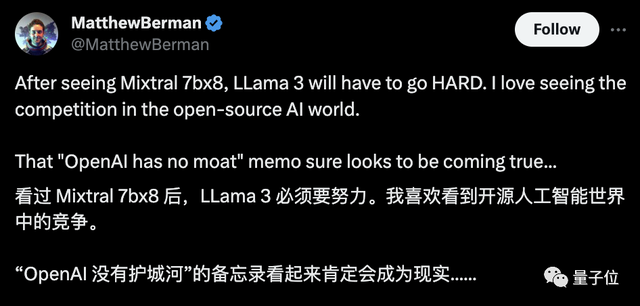

不少網友是已經興奮起來了:

“OpenAI沒有護城河”,看起來肯定會成爲現實……

要知道,Mistral AI今年5月纔剛剛成立。

短短半年,已是一手20億美元估值,一手驚豔整個AI社區的模型。

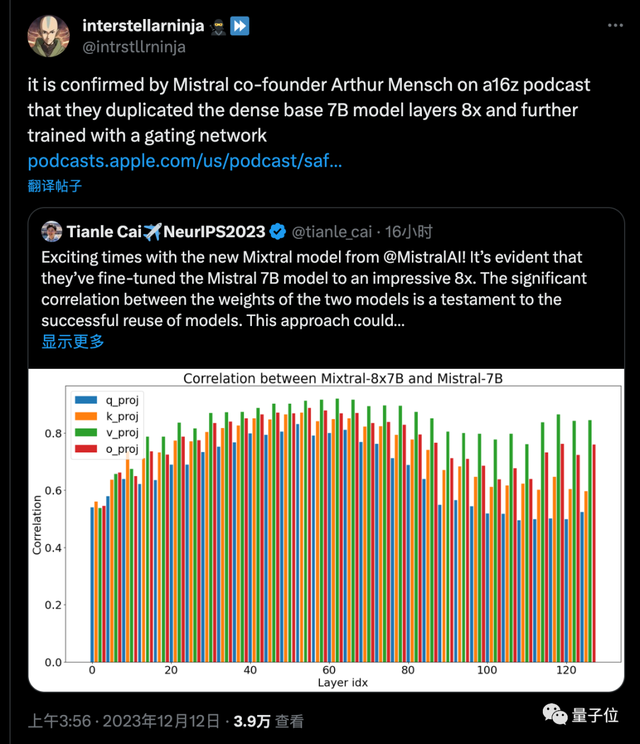

更關鍵的是,普林斯頓博士生Tianle Cai分析了Mistral-7B與Mixtral-8x7B模型的權重相關性做了分析,證明了模型的成功複用。

隨後網友發現,Mistral AI創始人也親自證實,MoE模型確實就是把7B基礎模型複製8次,再進一步訓練來的。

隨着此類模型的免費商用,整個開源社區、新的創業公司都可以在此基礎之上推動MoE大模型的發展,就像Llama已然帶動的風暴那樣。

作爲吃瓜羣衆,只能說:

參考鏈接:

[1]https://mistral.ai/news/mixtral-of-experts/

[2]https://mistral.ai/news/la-plateforme/

[3]https://huggingface.co/blog/mixtral#about-the-name

如若转载,请注明出处:https://www.tuio.cc/1609.html