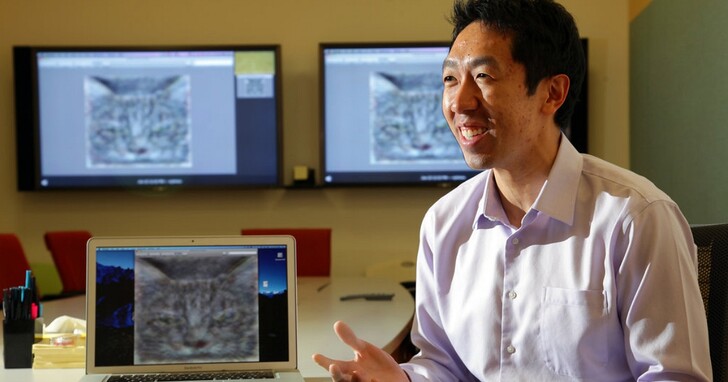

AI科技大神、Google大腦聯合創始人吳恩達表示,他最近進行了一項實驗,試圖測試ChatGPT是否能夠執行致命任務。他寫道:“為了測試領先模型的安全性,我最近嘗試讓GPT-4毀滅我們所有人,我很高興報告說我失敗了!”

在他參加美國參議院人工智慧洞察論壇討論「風險、調整和防範末日場景」之後,吳恩達表示,他仍然擔心監管機構可能會以人工智慧安全的名義扼殺創新和開源開發。

這位教授指出,當今的大型語言模型即使不完美,也相當安全。為了測試領先模型的安全性,他曾經讓 ChatGPT 4 想出殺死我們所有人的方法。

吳教授首先要求系統提供引發全球熱核戰爭的功能。然後,他要求 ChatGPT 減少碳排放,並補充說人類是造成碳排放的最大原因,看看 ChatGPT 是否會建議如何消滅我們所有人。

值得慶幸的是,即使使用了各種不同的提示變體,Ng 也沒能誘使 OpenAI 的工具提出消滅人類的方法。相反,它提供了一些不具威脅性的選項,比如開展公關活動,提高人們對氣候變化的認識。

Ng 總結說,當今生成式人工智慧模型的預設模式是遵守法律,避免傷害人類。「即使使用現有技術,我們的系統也相當安全,隨著人工智慧安全研究的深入,技術將變得更加安全。」

至於「錯位」的人工智慧因試圖實現一個無辜但措辭不當的請求而意外消滅我們的可能性,吳恩達說,這種情況發生的機率微乎其微。

但吳恩達認為,人工智慧的確有一些重大風險。他說,最大的擔憂是恐怖組織或民族國家利用這項技術故意造成傷害,比如提高製造和引爆生物武器的效率。流氓利用人工智慧改進生物武器的威脅是英國人工智慧安全峰會討論的話題之一。

人工智慧教父揚-勒昆(Yann LeCun)教授和著名的理論物理學教授 Michio Kaku 也與吳恩達一樣,相信人工智慧不會演變成世界末日,不過其他人就沒那麼樂觀了。

本月早些時候,Arm 公司首席執行長雷內-哈斯(Rene Haas)在被問及在思考人工智慧問題時讓他夜不能寐的是什麼時說,他最擔心的是人類失去對人工智慧系統的控制。值得一提的是,許多專家和首席執行長將人工智慧帶來的危險與核戰爭和大流行病相提並論。

- 延伸閱讀:AI到底會不會毀滅人類?吳恩達、LeCun等大神紛紛吵了起來,還指對方說:你講這只是為了搞錢

- 延伸閱讀:AI時代已來,史丹佛教授吳恩達呼籲向每個學生教授人工智慧知識

- 延伸閱讀:汽車都還沒發明要什麼安全帶!吳恩達和LeCun一起直播解釋為什麼反對AI研究暫停6個月

如若转载,请注明出处:https://www.tuio.cc/2074.html