ADVERTISEMENT

通用人工智慧 (AGI),又常被稱為「強人工智慧」、「全面人工智慧」、「人類水準人工智慧」或「通用智慧行為」,代表了人工智慧領域未來的一大飛躍。不像針對特定任務的窄人工智慧 (例如檢測產品瑕疵、總結新聞或建構網站),AGI 將能夠執行廣泛的認知任務,達到或超越人類水準。

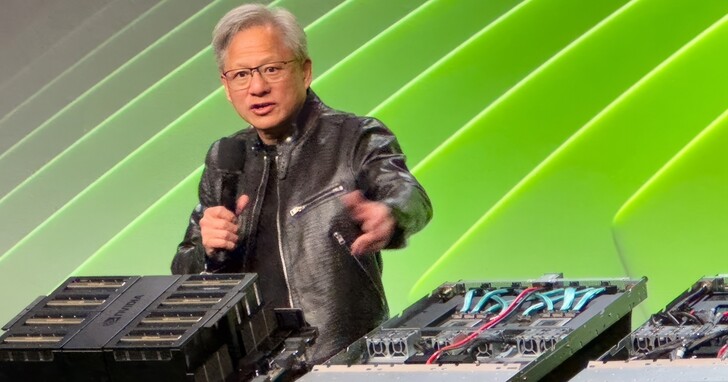

Nvidia 首席執行長黃仁勳 (Jensen Huang) 在自家公司年度 GTC 開發者大會上,對於被反復詢問 AGI 時間框架感到厭煩。這類問題之所以頻繁出現,是因為人們擔心未來機器在幾乎所有領域都能超越人類的思考、學習和表現能力,進而引發人類在其中扮演的角色以及掌控能力等關於存在的本質方面的問題。 核心問題在於 AGI 的決策過程和目標不可預測,它們可能與人類的價值觀或優先順序不一致 (科幻小說從至少 1940 年代起就深入探討了這一概念)。 人們擔心一旦 AGI 達到一定程度的自主性和能力,就可能無法控制,導致其行為無法預測或逆轉。

黃仁勳認為,預測何時會出現合格的 AGI 取決於你如何定義 AGI。他透過類比來解釋:即使存在時區問題,你也知道新年是什麼什麼時候到來以及 2025 年什麼時候到來。 如果你開車前往聖荷西會議中心 (今年的 GTC 大會舉辦地),當你看到巨大的 GTC 橫幅廣告時,你就知道自己到了。 關鍵點在於我們可以就到達的方式達成共識,無論是在時間上還是地理位置上,亦或是你想要去的地方。

黃仁勳解釋道:「如果我們將 AGI 指定為非常具體的東西,一套軟體程式可以做得非常好的測試,或者比大多數人好 8%,我相信我們會在 5 年內實現它。」他建議這些測試可以是法律資格考試、邏輯測試、經濟測試,或者可能是通過醫學院入學考試的能力。除非提問者能夠非常具體地說明 AGI 在問題中的含義,否則他不會願意做出預測。這也可以理解。

- 延伸閱讀:以推特和特斯拉為燃料,馬斯克被整合併特斯拉和Neuralink打造通用人工智慧AGI

- 延伸閱讀:3D 遊戲之父約翰‧卡馬克認為,實現AGI通用人工智慧的正路不是ChatGPT

AI 幻覺可解

在週二的問答環節中,有人問黃仁勳如何處理 AI 幻覺,即一些 AI 會編造聽起來合理的答案,但並非基於事實的傾向。黃仁勳顯然對這個問題感到沮喪,並表示只要確保答案經過了充分的研究,就可以輕鬆解決幻覺問題。

黃仁勳將這種做法稱為「檢索增強生成」,他引用這種非常類似於基本媒體素養的方法來描述這一過程:「加入一個規則:對於每個答案,都必須查閱答案來源。」 也就是檢查來源和上下文。將來源中包含的事實與已知的真相進行比較,如果答案在事實上是不準確的,即使部分不準確,也要丟棄整個來源並繼續尋找下一個來源。「AI 不應該只是回答,它應該首先進行研究以確定哪個答案是最好的。」

對於諸如健康建議等關鍵任務的答案,Nvidia 的首席執行長建議或許可以檢查多個資源和已知的事實來源。這當然意味著生成答案的工具需要能夠選擇說「我不知道這個問題的答案」或「我無法就這個問題的正確答案達成共識」,甚至可以像這樣說「嘿,超級盃還沒舉行,所以我不知道誰贏了」。

- 延伸閱讀:馬斯克為xAI設定目標:2029年實現通用人工智慧,這是最後期限

- 延伸閱讀:Google DeepMind創始人提出通用人工智慧分級框架:ChatGPT還只能算是初級

資料來源:

- Nvidia’s Jensen Huang says AI hallucinations are solvable, artificial general intelligence is 5 years away

如若转载,请注明出处:https://www.tuio.cc/2165.html