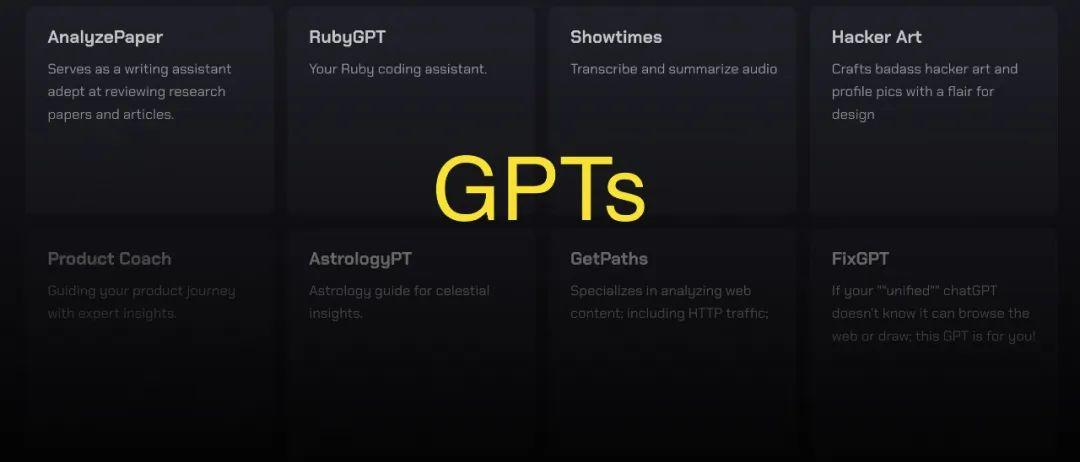

好消息,搞生成式AI應用的門檻,被狠狠地打下去了!就在剛剛,亞馬遜雲科技在年度盛會re:Invent中正式宣佈:

在我這搞生成式AI應用,主流、最新大模型隨便用~

例如Meta家的Llama 2 70B、Antropic家的Claude 2.1等等:

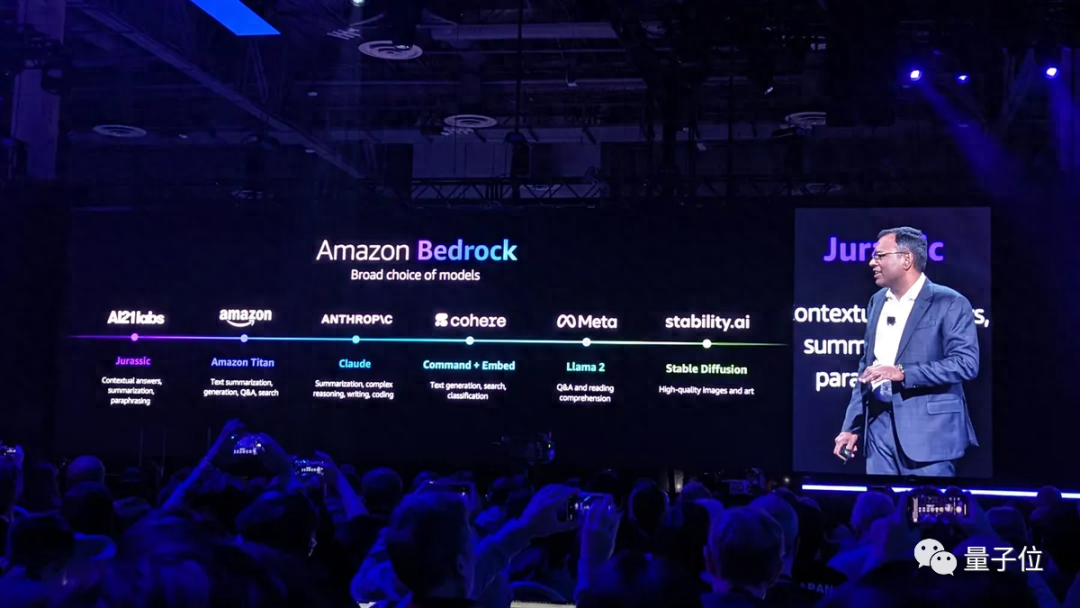

能夠將如此衆多大模型“打包”起來的集大成者,便是亞馬遜雲科技的AI大模型服務

亞馬遜的基石

。

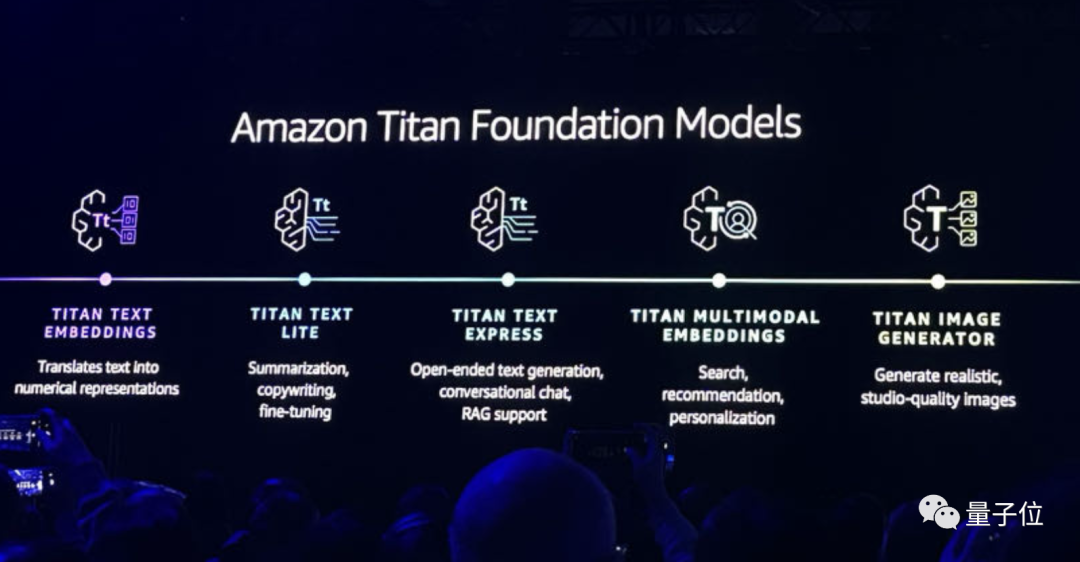

當然,其中也包含了自家最新升級的大模型

泰坦

:

- Titan Text Embeddings:將文本轉變爲數字表徵;

- Titan Text Lite:可執行對文本的總結、文案生成和微調;

- Titan Text Express:開放式文本生成、會話聊天,並支持RAG;

- Titan Multimodel Embeddings:支持搜索、推薦和個性化定製;

- Titan Image Generator:可生成超現實、影棚級質量的圖片。

亞馬遜雲科技AI副總裁Swami Sivasubramanian,還在現場演示了Titan Iamge Generator的能力。

例如只需一句話就可以將一隻綠色蜥蜴,毫無PS痕跡地變成橘色:

再如把圖片掉轉個方向,也是隻是一句話的事兒了:

方便,着實是方便。

不過縱觀整場發佈會,這些個功能和升級也還僅是亞馬遜雲科技把門檻打下去的動作一隅。

還有更多新功能的發佈,讓搞生成式AI應用變得簡單了不少。

SageMaker上新

SageMaker是亞馬遜雲科技長期押注的一個項目,它的主要作用便是構建、訓練和部署機器學習模型。

Swami在今天的大會中宣佈了它的諸多新功能,讓客戶可以更輕鬆地去構建、訓練和部署生成式AI模型。

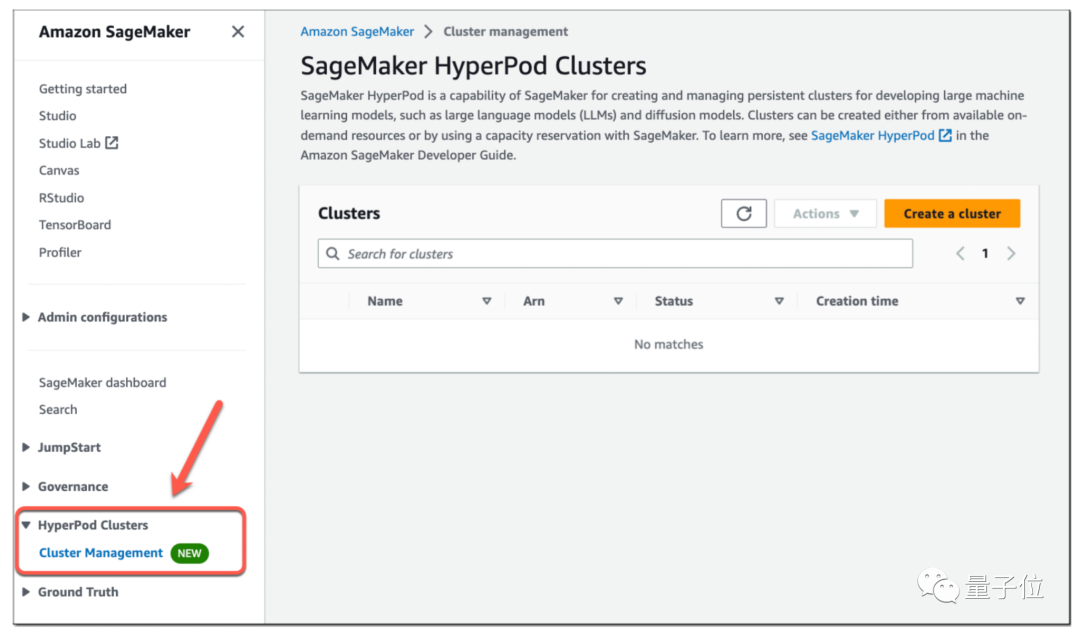

首先,便是

SageMaker HyperPod

功能。

我們都知道,以往基礎模型通常過於複雜,無法使用單個 AI 芯片進行訓練;因此,它們必須拆分到多個處理器上,這是一項技術上覆雜的工作。

而SageMaker HyperPod可以提供對按需AI訓練集羣的訪問,開發人員可以通過點擊式命令和相對簡單的腳本組合來配置集羣,這比手動配置基礎架構要快得多。

Swami在現場表示:

SageMaker HyperPod將訓練基礎模型所需的時間減少了40%。

SageMaker HyperPod不僅可以自動執行設置AI訓練集羣的過程,它還可以自動執行其維護。

當客戶集羣中的某個實例脫機時,內置的自動化軟件會自動嘗試修復它;如果故障排除嘗試不成功,SageMaker HyperPod 會將出現故障的節點換成新節點。

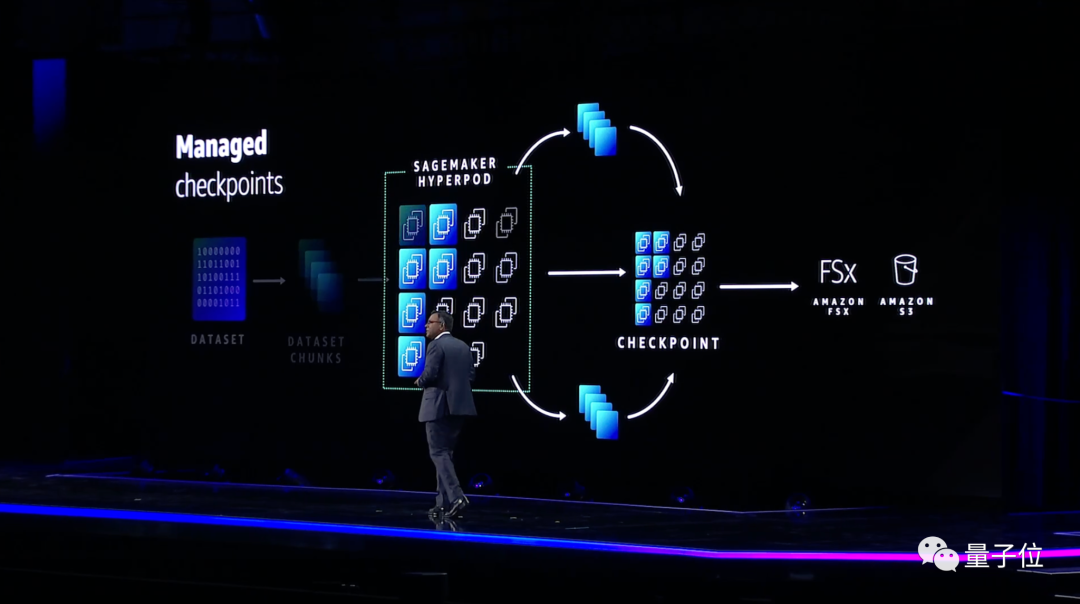

在某些情況下,基礎模型需要數週或數月的時間來訓練。如果中斷使底層 AI 基礎設施脫機,開發人員必須從頭開始重新開始訓練,這可能會導致嚴重的項目延遲。

爲避免此類情況,SageMaker HyperPod 會在訓練期間定期保存AI模型,並提供從最新快照恢復訓練的功能。

不僅如此,每個SageMaker HyperPod集羣都預配置了一組亞馬遜雲科技開發的分佈式訓練庫。

這些庫會自動將開發人員的模型分散到集羣中的芯片上,而且還可以將訓練該模型的數據拆分爲更小,更易於管理的部分。

其次,在推理方面,亞馬遜雲科技推出了

SageMaker推理

功能。

它的出現將有助於降低模型的部署成本和延遲;新的推理功能可以讓客戶單個端點上部署一個或多個基礎模型,並控制分配給它們的內存和加速器數量。

具體降本增效的成果,亞馬遜雲科技在現場也有介紹:

這項新功能可以幫助將部署成本降低50%,並將延遲減少20%。

在構建機器學習模型的無代碼界面上的

SageMaker帆布

也有所更新。

我們現在可以直接用自然語言去處理了!

在聊天界面中,SageMaker Canvas提供了許多與您正在使用的數據庫相關的引導提示,或者你可以提出自己的提示。

例如,你可以通過說“準備數據質量報告”、“根據特定條件刪除行”等等,讓它來執行你的需求。

……

總而言之,SageMaker今天的衆多能力更新,着實是讓模型的構建、訓練和部署簡單了不少。

對數據也“下手”了

擁有強大的數據基礎,對於充分利用生成式AI可以說是至關重要。

Swami在現場表示,強大的數據基礎需要滿足三點:全面(comprehensive)、集成(integrated)和治理(governed)。

圍繞這些特性,亞馬遜雲科技在今天的大會中也做了相應新功能的發佈。

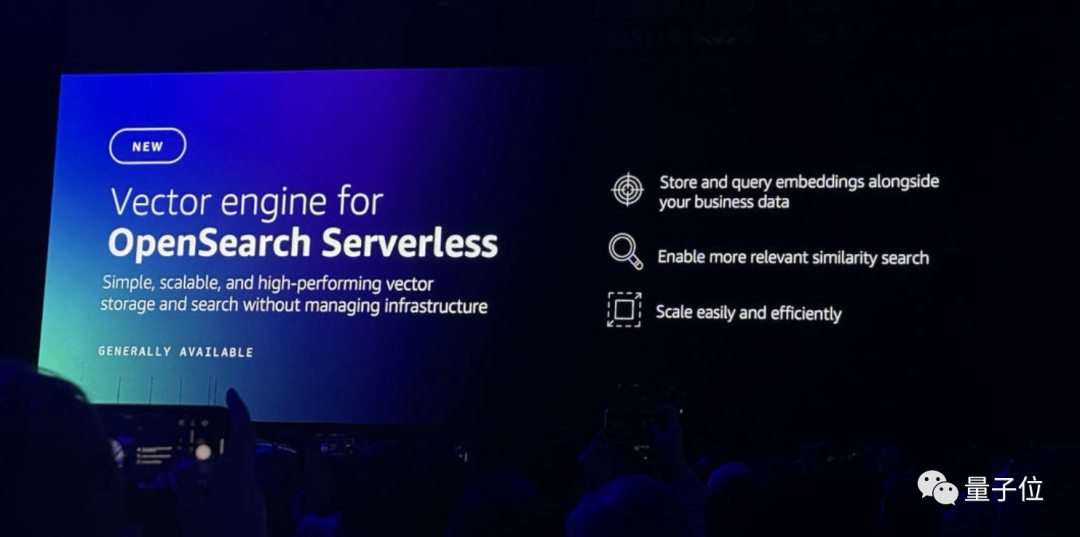

首先便是針對向量引擎的

OpenSearch 無服務器

,它能夠帶來更高效的搜索和流程。。

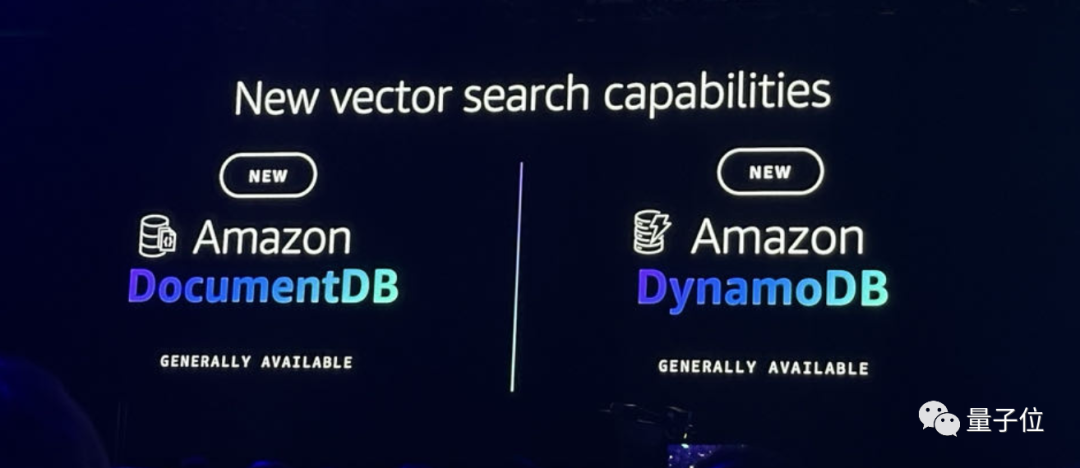

其次,

文檔數據庫

和

DynamoDB

也加入到了向量功能,可以允許用戶將多種數據存儲在一起。

除此之外,

Redis的MemoryDB

也有了相應更新,它也可以支持向量搜索,響應時間變得更快,每秒可以處理數萬個查詢。

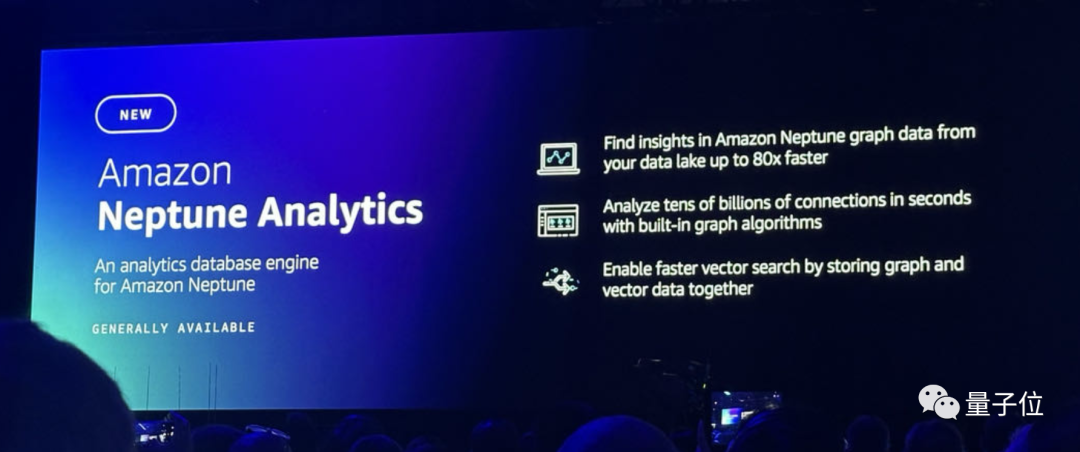

在分析數據庫方面,亞馬遜雲科技則是推出了

亞馬遜海王星分析

,可以讓開發人員在幾秒鐘內檢查海量的圖形數據,也支持更快的向量搜索。

在數據的“集成”特性方面,亞馬遜雲科技依舊堅持的是“zero-ETL”之道——Amazon S3加持下的OpenSearch Service zero-ETL integration,僅使用一個工具,便可以分析S3中的所有操作數據。

最後,在“治理”方面,亞馬遜雲科技上新的功能便是

潔淨室ML

。

它可以允許用戶在不共享底層數據的情況下與客戶應用機器學習模型。

還有一件事

在推動大模型發展的這件事上,亞馬遜雲科技可以說是有着自己獨到的“玩法”——

不僅發展自家的大模型,更是給其它大模型提供AI基礎設施和AI工具,讓它們也能更好地發展。

那麼二者之間是否會存在衝突和競爭呢?

在量子位與亞馬遜雲科技數據庫和遷移服務副總裁Jeff Carter的交流過程中,他發表瞭如下看法:

我希望我們生活在一個合作的世界裏,每個LLM都擅長於不同的方面,我認爲這種情況會持續下去,這種專業化水平也會持續一段時間。

我喜歡Bedrock的一個原因是它可以無縫地從一個LLM轉換到另一個LLM。很明顯,亞馬遜將持續在LLM方面推進最先進的技術。

但對於每個LLM,或許下個月所呈現出來的能力會截然不同,這也就是爲什麼我們認爲給客戶提供選擇的能力和同時使用多個功能的能力是如此重要的原因之一。

參考鏈接:

[1]https://press.aboutamazon.com/2023/11/aws-announces-more-model-choice-and-powerful-new-capabilities-in-amazon-bedrock-to-securely-build-and-scale-generative-ai-applications

[2]https://www.techradar.com/news/live/aws-reinvent-2023-all-the-news-updates-and-more

如若转载,请注明出处:https://www.tuio.cc/374.html