網友:看來還未觸及極限

微軟最新研究再次證明

提示工程

的威力——

無需額外微調,無需專家策劃,僅憑提示,GPT-4就能化身“專家”。

使用他們提出的最新提示策略

醫療提示

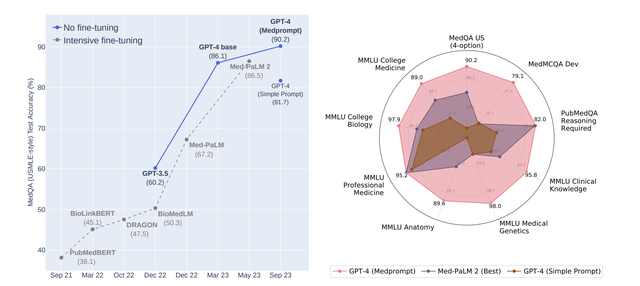

,在醫療專業領域,GPT-4在MultiMed QA九個測試集中取得最優結果。

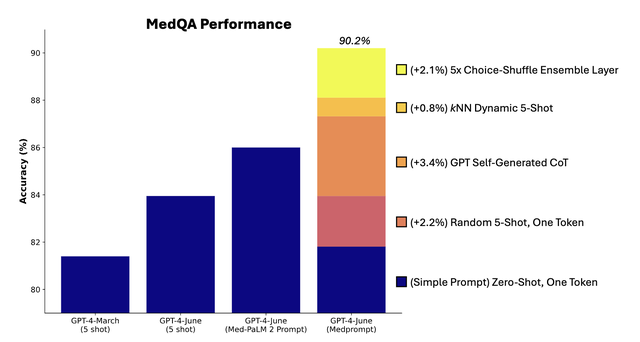

在MedQA數據集(美國醫師執照考試題)上,Medprompt讓GPT-4的準確率首次超過90%,超越BioGPT和Med-PaLM等一衆微調方法。

研究人員還表示Medprompt方法是通用的,不僅適用於醫學,還可以推廣到電氣工程、機器學習、法律等專業中。

這項研究在X(原Twitter)一經分享,就引發衆多網友關注。

沃頓商學院教授Ethan Mollick、Artificial Intuition作者Carlos E. Perez等都有轉發分享。

Carlos E. Perez直呼“出色的提示策略可以甩微調一大截”:

有網友表示早就有這種預感,現在能看到結果出來,真的是“so cool”:

還有網友表示這真的很“激進”:

GPT-4是一項能改變行業的技術,而我們還遠沒有觸及提示的極限,也未達到微調極限。

組合提示策略,“變身”專家

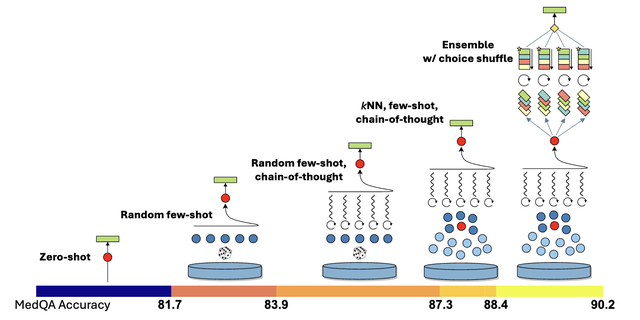

Medprompt是多種提示策略的組合體,包含三大法寶:

- 動態少樣本選擇(Dynamic few-shot selection)

- 自生成思維鏈(Self-generated chain of thought)

- 選項洗牌集成(Choice shuffling ensemble)

下面我們來一一介紹。

動態少樣本選擇

少樣本學習可以說是讓模型快速學習上下文的一種最有效的方法。簡單來說,就是輸入一些示例,讓模型快速適應特定領域,並學習遵循任務的格式。

這種用於特定任務提示的少樣本示例通常是

固定的

,所以對示例的代表性和廣泛性有較高的要求。

之前一種方法是讓領域專家

手動製作範例

,但即便如此,也不能保證專家策劃的固定的少樣本示例在每個任務中都有代表性。

因此,微軟研究人員提出了動態少樣本示例的方法。

想法是,任務訓練集可以作爲少樣本示例的來源,如果訓練集足夠大,那就可以爲不同的任務輸入選擇不同的少樣本示例。

具體來說,研究人員先利用text-embedding-ada-002模型爲每個訓練樣本和測試樣本生成向量表示。然後,對於每個測試樣本,基於向量相似度,從訓練樣本中挑選出最相似的k個樣本。

與微調方法相比,動態少樣本選擇利用了訓練數據,但不需要對模型參數進行大量更新。

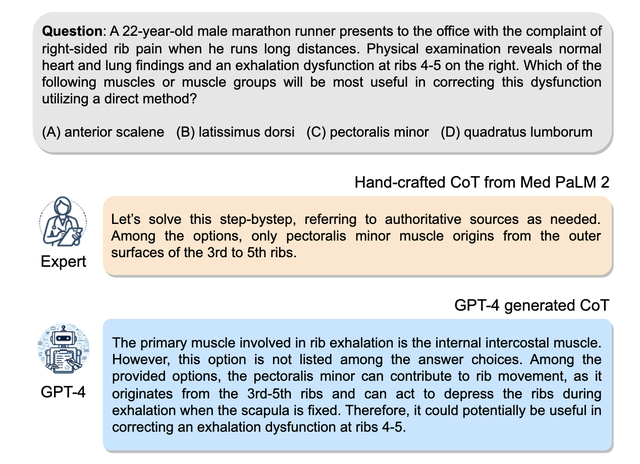

自生成思維鏈

思維鏈(CoT)方法就是讓模型一步一步思考,生成一系列中間推理步驟。

之前一種方法也是依賴專家手動編寫少量的帶有提示思維鏈的示例。

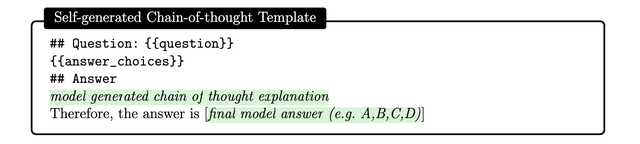

在這裏,研究人員發現,可以簡單地要求GPT-4使用以下提示爲訓練示例生成思維鏈:

但研究人員也指出這種自動生成的思維鏈可能包含錯誤的推理步驟,於是設置了一個驗證標籤作爲過濾器,可以有效減少錯誤。

與在Med-PaLM 2模型中專家手工製作的思維鏈示例相比,GPT-4生成的思維鏈基本原理更長,而且分步推理邏輯更細粒度。

選項洗牌集成

除此之外,GPT-4在做選擇題時,可能會存在一種偏見,就是不管選項內容是什麼,它會偏向總是選擇A,或者總是選擇B,這就是位置偏差。

爲了減少這個問題,研究人員選擇將原來的選項順序打亂重排。比如原先選項是ABCD,可以變成BCDA、CDAB。

然後讓GPT-4做多輪預測,每輪使用選項的一個不同排列順序。如此一來“迫使”GPT-4考慮選項的內容。

最後對多輪預測結果做個投票,選擇最一致、正確的選項。

將以上幾種提示策略組合在一起就是Medprompt,下面來看測試結果。

多項測試最優

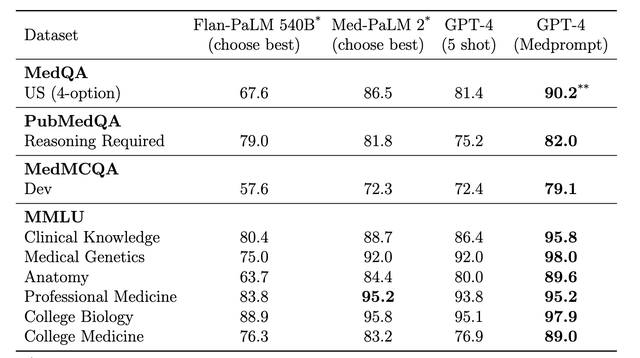

在測試中,研究人員採用了MultiMed QA評估基準。

使用Medprompt提示策略的GPT-4,在MultiMedQA的九個基準數據集中均取得最高分,優於Flan-PaLM 540B、Med-PaLM 2。

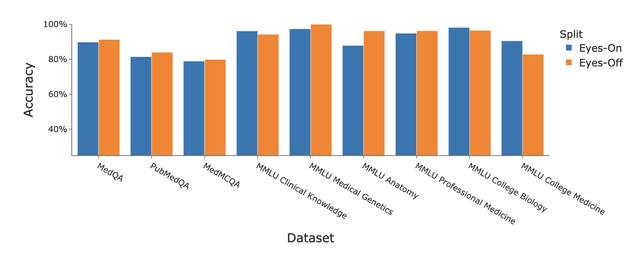

此外研究人員還討論了Medprompt策略在“Eyes-Off”數據上的表現,也就是在訓練或優化過程中模型未曾見過的數據中的表現,用於檢驗模型是否過擬合訓練數據。

結果GPT-4結合Medprompt策略在多個醫學基準數據集上表現出色,平均準確率達到了91.3%。

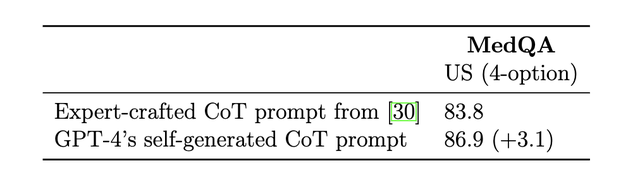

研究人員還在MedQA數據集上進行了消融實驗,探索了三個組件對於整體性能的相對貢獻。

其中自動生成思維鏈步驟對性能提升的貢獻最大。

而且GPT-4自動生成的思維鏈比Med-PaLM 2中專家策劃的得分更高:

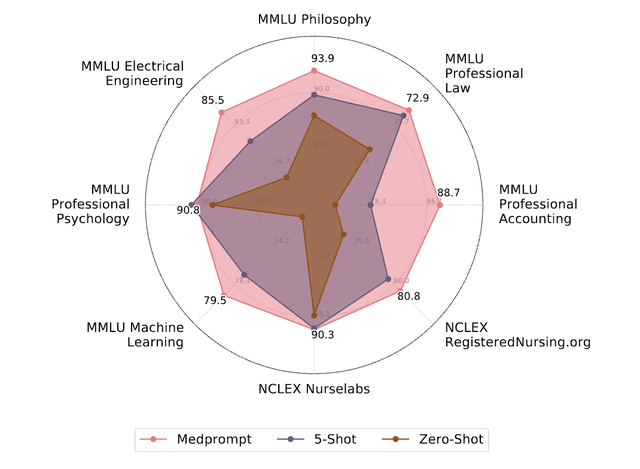

最後,研究人員還探索了Medprompt的跨域泛化能力,取用了MMLU基準中的六個不同的數據集,涵蓋了電氣工程、機器學習、哲學、專業會計、專業法律和專業心理學的問題。

還添加了另外兩個包含NCLEX(美國護士執照考試)問題的數據集。

論文鏈接:https://arxiv.org/pdf/2311.16452.pdf

參考鏈接:

[1]https://twitter.com/erichorvitz/status/1729854235443884385

[2]https://twitter.com/emollick/status/1729733749657473327

如若转载,请注明出处:https://www.tuio.cc/483.html