智通財經APP獲悉,CPU與GPU雙產業巨頭、英偉達(NVDA.US)競爭對手之一AMD(AMD.US)於美東時間週三舉行“Advancing

AI”發佈會,AMD宣佈正式推出其旗艦款AI

GPU加速器MI300X,意味着AMD與英偉達之間的激烈競爭從PC領域全面延伸至AI領域,AMD測試數據顯示其整體性能比英偉達H100高出60%。除了如預期發佈諸如Instinct

MI300X、MI300A等新產品外,在AI領域的一些全球領軍者也來到現場,比如OpenAI、微軟以及Meta,並表示他們後續將大量配置AMD

Instinct MI300X。

“Advancing AI”發佈會上,首先登場的是Instinct

MI300X加速器,由於MI300系列AI芯片的參數在半年前的產品宣傳活動上就已經公佈,本次“Advancing

AI”發佈會更多聚焦於整套系統在實際應用中的表現,以及與AI訓練/推理領域熱度最高的英偉達H100

AI芯片的全方位性能對比。此外,

AMD將截至2027年的全球AI芯片市場規模預期,從1500億美元猛然上修至4000億美元。

AI領域的全球領軍者OpenAI、微軟(MSFT.US)以及Meta(META.US)週三在AMD活動上表示,他們將使用AMD最新的AI芯片Instinct

MI300X。這是迄今爲止全球科技公司正在尋找昂貴的英偉達H100

AI芯片替代品的最明顯跡象。

英

偉達H100對於創建和部署OpenAI旗下的ChatGPT等生成式人工智能(生成式AI)應用程序至關重要,如今AI芯片領域幾乎處於壟斷地位的英偉達H100終於有了強力競爭對手,那就是AMD

Instinct MI300X。

如果AMD最新的高端AI芯片在明年初開始出貨時,足以滿足構建人工智能大模型的科技公司和雲服務提供商的算力需求,同時降低科技公司開發人工智能模型的成本,勢必將對英偉達旗下銷售額不斷飆升的AI芯片構成巨大的競爭壓力。

AMD首席執行官蘇姿豐(Lisa Su)週三表示:“潛在大客戶的所有興趣基本上集中在雲計算領域的大型處理器和大型GPU上。”

AMD表示,MI300X基於一種全新的架構,這種架構通常會帶來顯著的性能提升。AMD

全新AI芯片最顯著的特點是擁有192GB的尖端高性能HBM3內存,傳輸數據速度更快,可以適應更大規模的人工智能模型。

被AMD粉絲們親切稱爲“蘇媽”的蘇姿豐在發佈會上直接將MI300X及其構建的系統與英偉達的主要AI芯片H100進行了比較。“這種性能直接轉化爲更好的用戶體驗,”蘇姿豐表示。“當你向模型提出要求時,你希望它能更快地回覆,尤其是在反應變得更復雜的情況下。”

AMD面臨的主要問題在於,一直以英偉達軟硬件爲基礎的公司是否會投入時間和金錢來信任另一家AI芯片供應商。

AMD週三告訴投資者和合作夥伴,該公司已經改進了名爲ROCm的配套軟件套件,以與英偉達的行業標準CUDA軟件相競爭,一定程度上解決了AMD在AI芯片領域面臨的一個關鍵缺陷——那就是軟硬件生態系統,而這個缺陷一直是人工智能開發者目前更喜歡英偉達旗下產品的主要原因之一。

AMD在週三並未透露MI300X的定價,但英偉達AI芯片每塊售價高達4萬美元,蘇姿豐表示,AMD的芯片必須比英偉達的芯片購買和運營成本更低,才能說服潛在大客戶購買。

雖然發佈會的內容基本上符合市場預期,但似乎未提振AMD股價。在週三美股科技股集體走弱的背景下,AMD發佈會還沒開完,股價就由漲轉跌,最終收跌超1%,但是盤後漲幅超過1%。

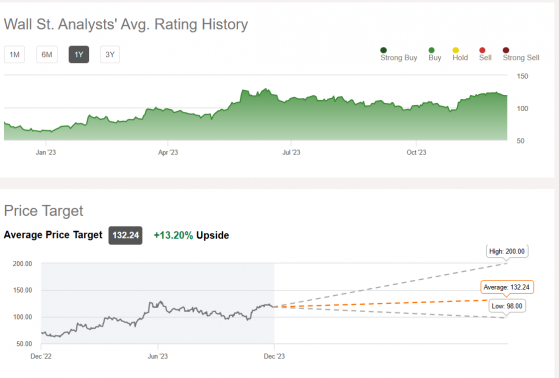

由於AMD即將推出與英偉達H100相抗衡的高性能AI 芯片,華爾街分析師們對於AMD股價普遍看漲,

Seeking

Alpha彙編的華爾街分析師共識評級以及目標價顯示,

華爾街分析師們對AMD的共識評級爲“買入”,平均目標價預期達132.24美元,意味着未來12個月潛在漲幅高達13%,最高目標價則爲200美元。

性能強於英偉達H100! AMD大幅上調市場規模預期

與AI訓練/推理領域熱度最高的英偉達H100

AI芯片的最新性能對比數據顯示,

在一般LLM內核TFLOP中,MI300X在FlashAttention-2和Llama 2

70B中提供較

英偉達H100

高達20%的性能提升幅度。

從平臺的角度來看,

將8x MI300X解決方案與8x 英偉達H100解決方案進行比較,AMD發現Llama 2

70B的增益程度要大得多,高達40%,Bloom 176B基準下的增益程度則高達60%。

具體的AMD Instinct MI300X與英偉達H100性能對比數據顯示:

在1v1比較中,整體性能比H100 (Llama 2 70B)提高20%

在1v1比較中,整體性能比H100 (FlashAttention 2)提高20%

8v8 服務器中的整體性能比 H100 (Llama 2 70B) 提高40%

在8v8服務器中,整體性能比 H100 (Bloom 176B) 提高60%

最新 MI300 AI芯片背後的驅動力是AMD ROCm

6.0。該軟件堆棧已更新到最新版本,具有強大的新功能,包括支持各種人工智能工作負載任務量,例如生成式人工智能和大語言模型(LLM)。

內存是AMD另一個巨大的升級領域,MI300X的HBM3容量比其前身MI250X(128

GB)增加了50%。爲了實現高達192GB的內存池,AMD爲MI300X配備了8個HBM3堆棧,每個堆棧都是12-Hi,同時整合了16Gb

IC,每個IC具有2GB容量,或每個堆棧具有高達24GB的容量。

該級別的內存規模將提供高達5.3TB/s的帶寬和896GB/s的Infinity Fabric帶寬。相比之下,英偉達即將推出的H200

AI芯片提供141GB容量,而英特爾Gaudi3 將提供141GB容量。

功耗方面,AMD Instinct MI300X的額定功率爲750W,比Instinct

MI250X的500W提升了50%,比NVIDIA H200多了50W。

AMD在週三對AI芯片領域的未來市場規模給出了大膽的預測數據,認爲AI芯片市場將迅猛擴張。具體來說,AMD預計AI芯片市場整體規模到2027年將達到超過4000億美元,較該公司幾個月前提供的1500億美元上調將近兩倍,凸顯全球各大企業對人工智能硬件的預期快速變化,各企業正在迅速佈局全新的AI產品。

有哪些科技巨頭將使用MI300X?

AMD在週三的發佈會上表示,該公司已經與一些最需要GPU的科技公司簽訂了使用該芯片的協議。根據研究公司Omidia最近的一份報告,Meta和微軟是2023年英偉達H100

AI芯片的最大規模買家。

在發佈會上,

Facebook和Instagram母公司Meta公開表示,該公司未來將大量使用MI300X

GPU處理人工智能推理工作負載,如處理人工智能貼紙、圖像編輯和操作其AI助手,並表示結合ROCm 軟件堆棧來支持AI推理工作負載。

微軟首席技術官Kevin

Scott公開表示,

微軟將通過其Azure網絡服務提供對MI300X芯片的技術訪問通道。此外,同日消息顯示,微軟未來將評估對AMD的AI芯片產品的需求,評估採用該新品的可行性。

ChatGPT開發商OpenAI表示,該公司將在一款名爲Triton的重要軟件產品中支持AMD

MI300等GPU

。Triton不是像GPT-4那樣的大語言模型,但對於人工智能研究領域來說是非常重要的產品。

英偉達最大規模客戶之一甲骨文表示,將在自己的雲計算服務體系中使用Instinct

MI300X加速器,並計劃基於AMD Instinct MI300X開發生成式AI服務。

AMD目前還沒有預測該AI芯片的長期銷售額,目前只給出了2024年預期,預計2024年數據中心GPU帶來的總營收規模約爲20億美元。僅在最近一個季度,英偉達的數據中心業務營收就超過140億美元,不過這一數據還包括GPU以外的業務。然而,AMD表示,未來四年,AI芯片領域的總市場規模可能將攀升至4000億美元,是該公司此前預測值的兩倍。

蘇姿豐還向記者表示,AMD並不認爲它需要擊敗英偉達才能在市場上取得好成績。在談到人工智能芯片市場時,蘇姿豐對記者表示:“我認爲很明顯,英偉達現在佔據絕大多數。”“我們認爲,到2027年,AI芯片市場規模可能會超過4000億美元,而我們將扮演重要角色。”

如若转载,请注明出处:https://www.tuio.cc/865.html