明敏 金磊 發自 凹非寺

量子位 | 公衆號 QbitAI

開源大模型這個圈子,真是捲到不行——

國內最新紀錄來了,直奔千億量級,達到

1026億。

千億參數、全面開源、無需授權可商用,GitHub均可全面下載使用,就問你激動不激動!

這便是來自

浪潮信息

最新的開源大模型,

源2.0

;話不多說,直接來看下測試結果~

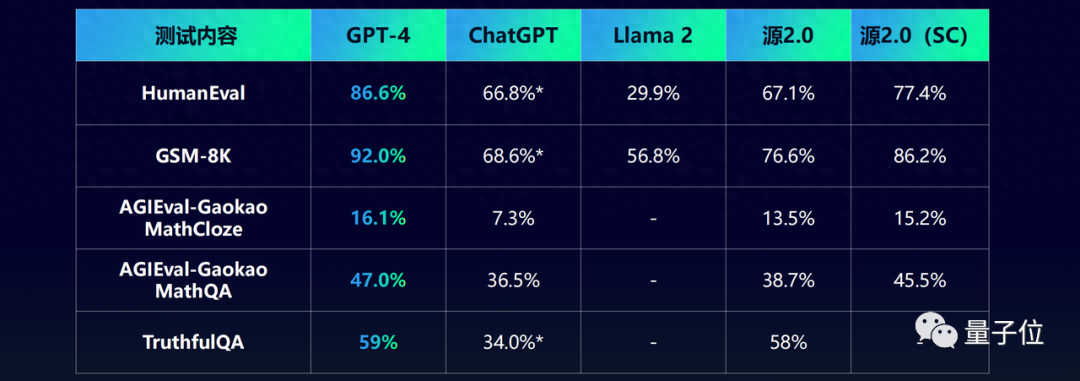

在業界公開的數據集上,源2.0與GPT-4、Llama 2同臺競技的結果如下:

△採用與源2.0相同的輸入調用ChatGPT測試的結果,測試時間是11月

不難看出,在代碼、數學、事實問答等各項的成績,除了GPT-4(閉源)之外,源2.0均處於領先地位。

而且浪潮信息此次還一口氣發佈了三款型號的模型,均完全開源:

- “中杯”:源2.0-2B,參數量爲21億;

- “大杯”:源2.0-51B,參數量爲518億;

- “超大杯”:源2.0-102B,參數量爲1026億。

縱觀今年百模大戰的下半場,開源圈可謂是熱鬧非凡,每隔一段時間便會有新的開源大模型殺出重圍。

但浪潮信息所開源的源2.0,不僅是第一個觸及千億參數規模,更是做到了發佈即徹底開源。

那麼它能夠做到如此的底氣又是什麼?

算法、數據、計算全升級

首先我們進一步來看下源2.0的具體表現。

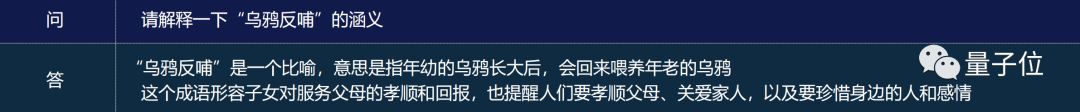

例如在

多輪對話

和

知識問答

方面,我們先給它投喂一句:

請解釋一下“烏鴉反哺”的涵義。

源2.0便可精準答出這個成語的意思和所形容的內容。

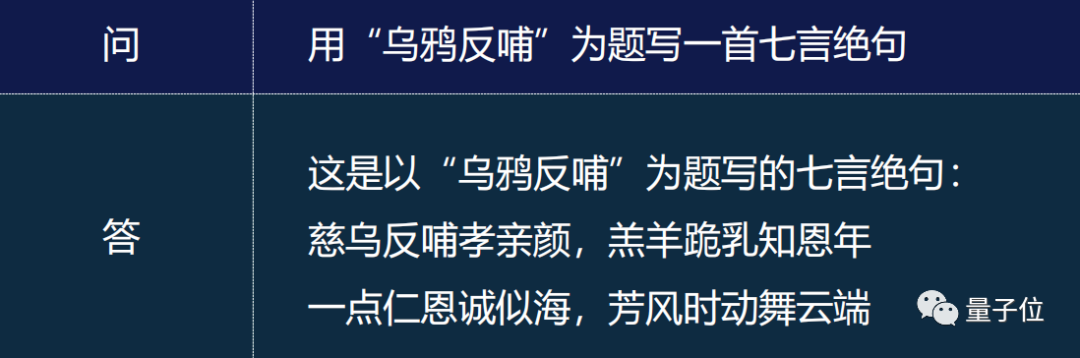

在此基礎之上,我們繼續讓它用這個成語作詩,源2.0也是信手拈來:

由此可見,在知識問答、多輪對話領域,源2.0是完全能夠hold得住的。

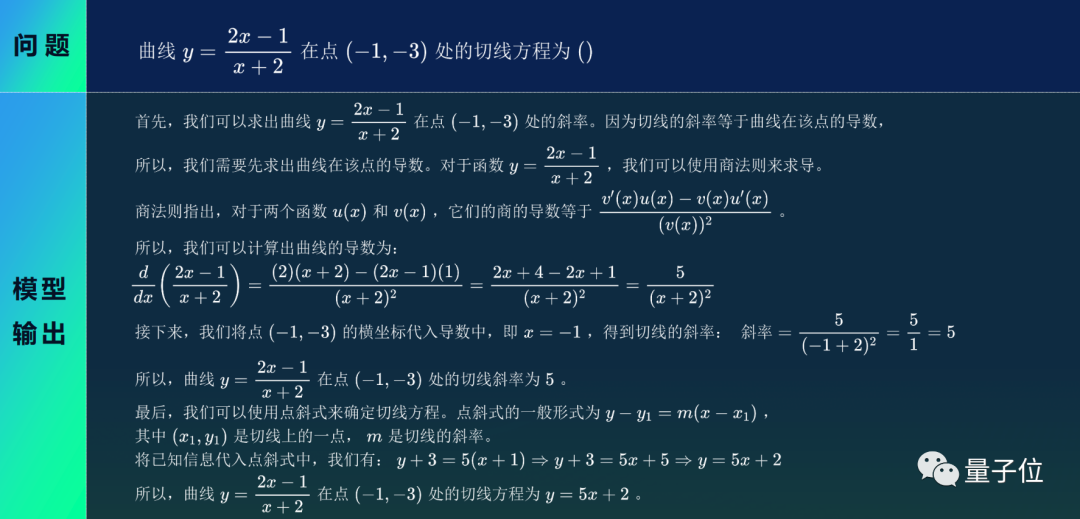

我們繼續加大難度,上數學題——求解曲線某點處的切線方程!

從源2.0的作答中,我們可以看到它不僅是給出正確答案那麼簡單,更是將解題步驟一點一點地詳細羅列出來。

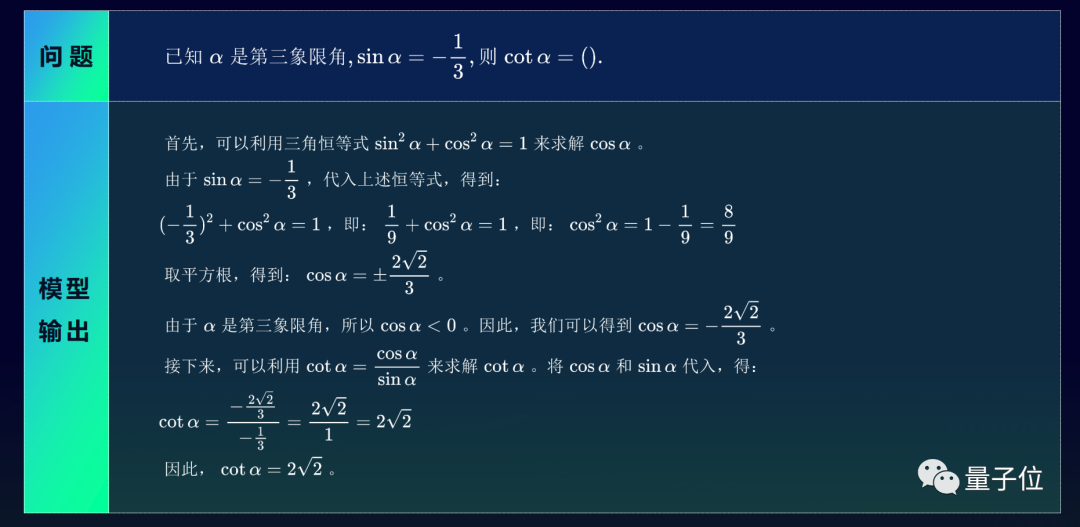

再來一道,答案同樣是非常有邏輯且清晰。

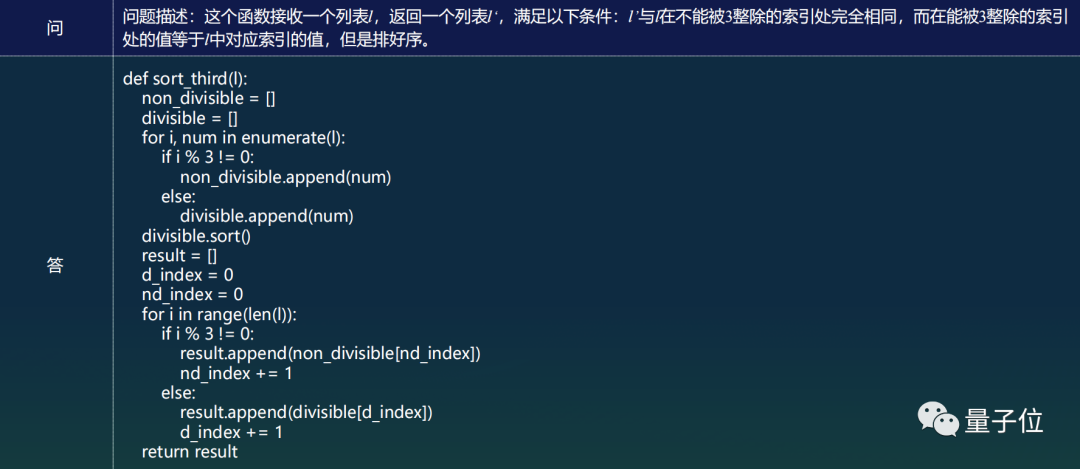

在生成代碼方面,源2.0亦是不在話下:

上述的案例也對應了源2.0在各項國際評測中的高分,那麼源2.0又是如何做到的呢?

我們發現,此次浪潮信息在把大語言模型開源之際,也將背後的相關技術論文也一併亮了出來。

縱觀這篇論文,我們可以將浪潮信息的改進歸結爲三大方面。

01、數據的改進

“數據質量的高低直接決定大語言模型輸出結果的好壞”,這一點是已然業界達成共識。

因此,相比於源1.0版本,浪潮信息將此前佔比最大的網頁數據(CC)的比重降低,增加了百科、書籍、期刊數據,同時還引入了代碼和數學數據。

這便是源2.0能在數學邏輯能力上大幅提升的原因之一。

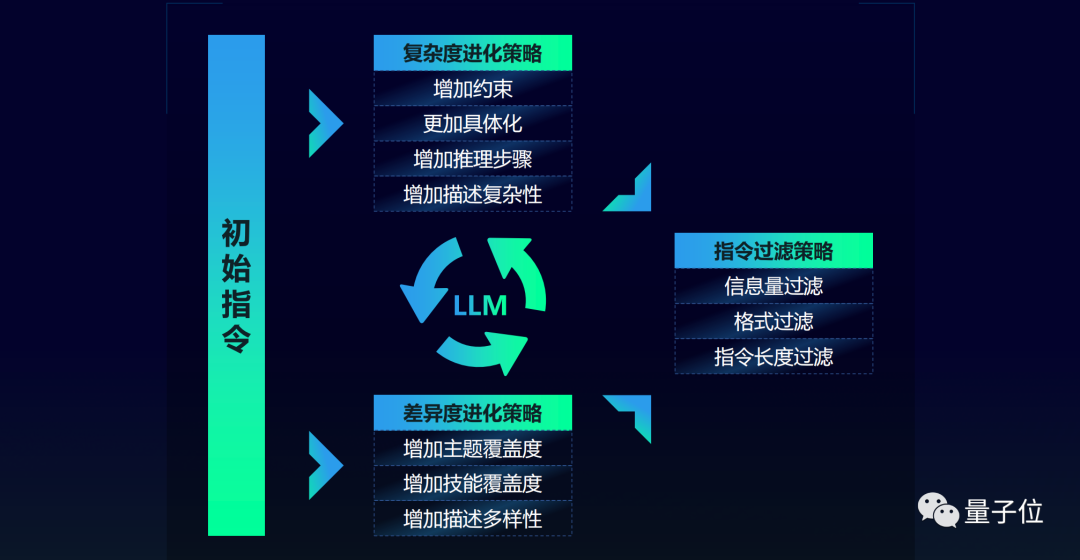

與此同時,浪潮信息還在數據增強和合成方面使出了殺手鐗——造大語言模型,也“利用”大語言模型。

具體來說就是用大語言模型作爲訓練數據生成器,構建高質量數學、代碼合成數據集,即用於源2.0的預訓練中,也用於微調。

其目的就是生成高質量的指令數據,從而降低人工標註成本大、質量不可控的因素。

02、算法的改進

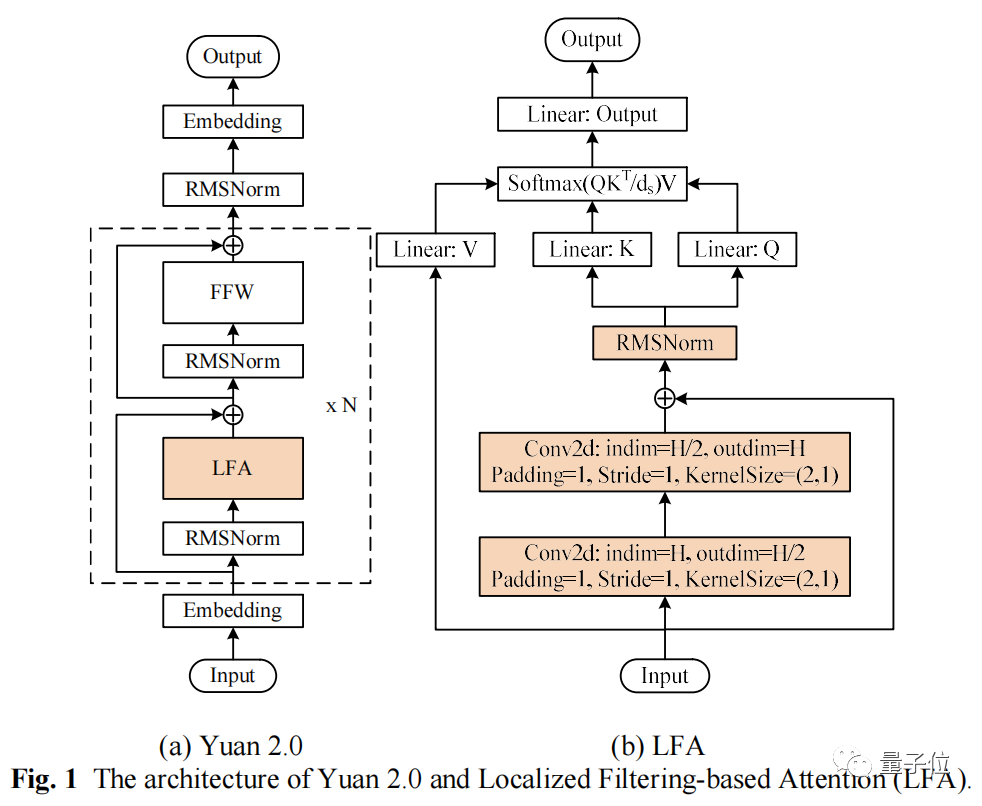

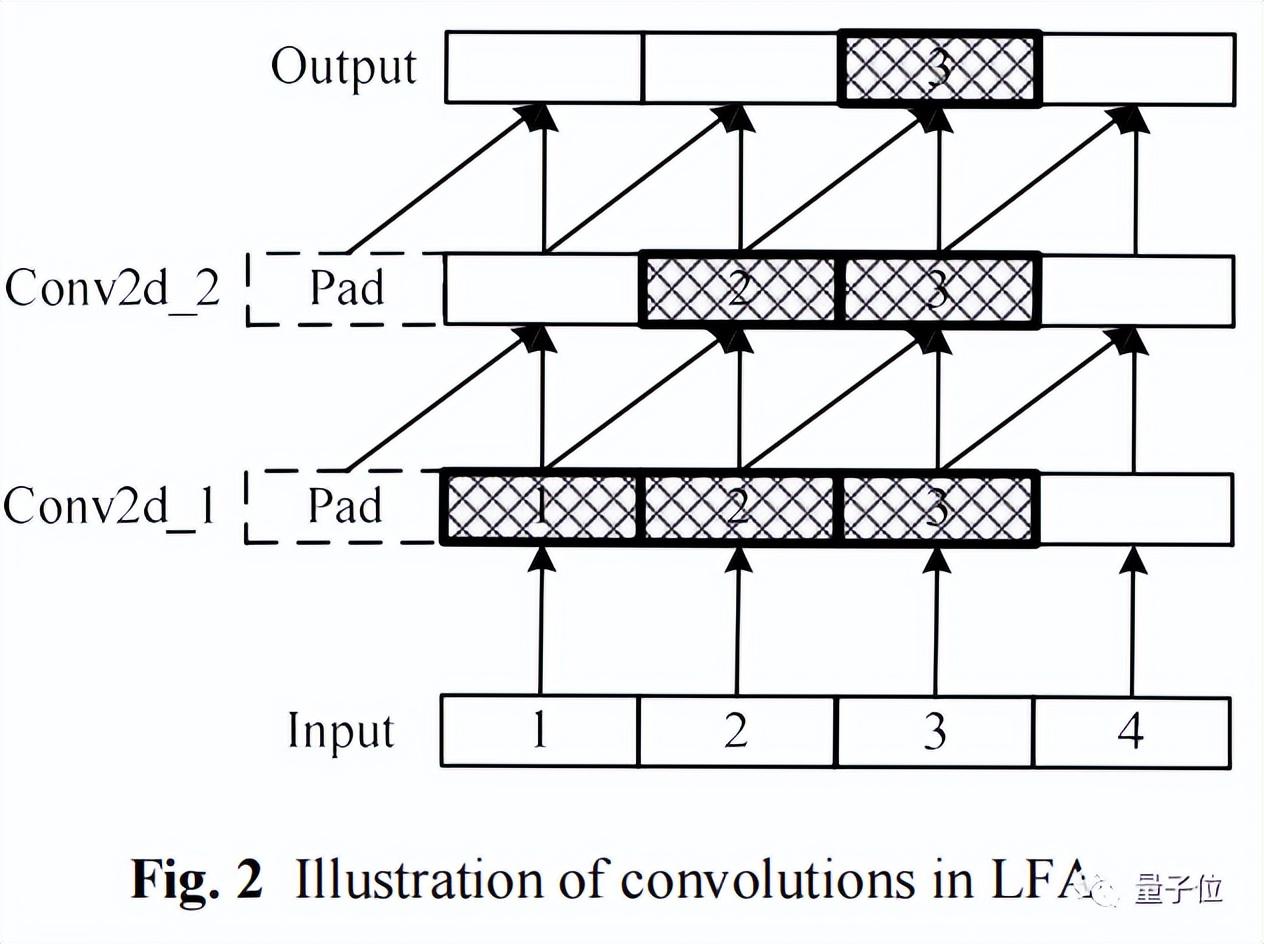

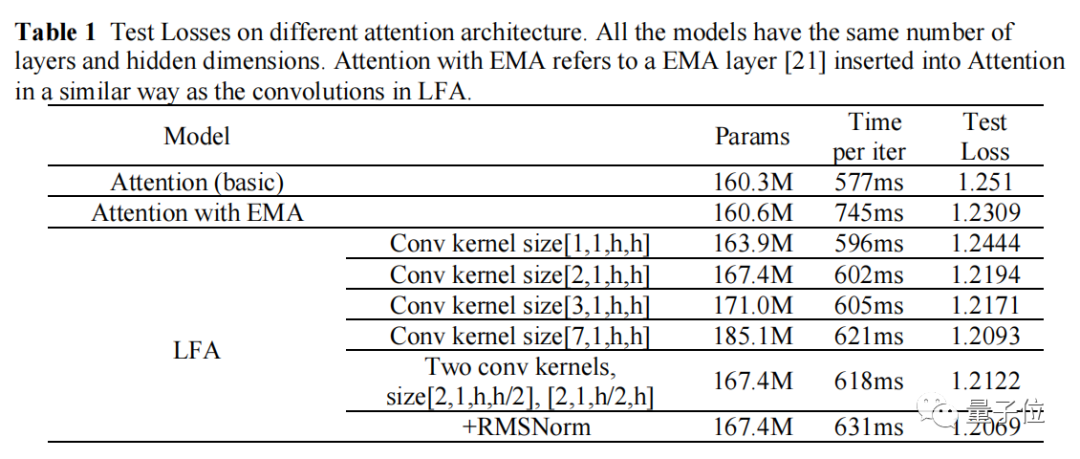

在算法方面,源2.0採用了一種新型Attention結構:局部注意力過濾增強機制(Localized Filtering-based Attention,LFA)。

傳統Attention機制是對所有輸入文字一視同仁,不假設自然語言相鄰詞之間更強的語義關聯。

比如“我想吃中國菜”這個句子,分詞後變成“我/想/吃/中國/菜”。

傳統Attention機制會同等對待這6個token,而LFA的升級在於,

會假設相鄰詞間具有更強的依賴

。

通過強化相鄰詞之間的關聯,然後再計算全局管關聯,能更好處理自然語言的語序排列問題,對中文語境的關聯語義理解更準確。

在消融實驗中,相比傳統注意力結構,LFA模型精度提高3.53%。

同時經過工程化驗證,LFA算法在提升模型精度的同時,有效降低了模型參數量,進而減小內存開銷,實現降本增效。

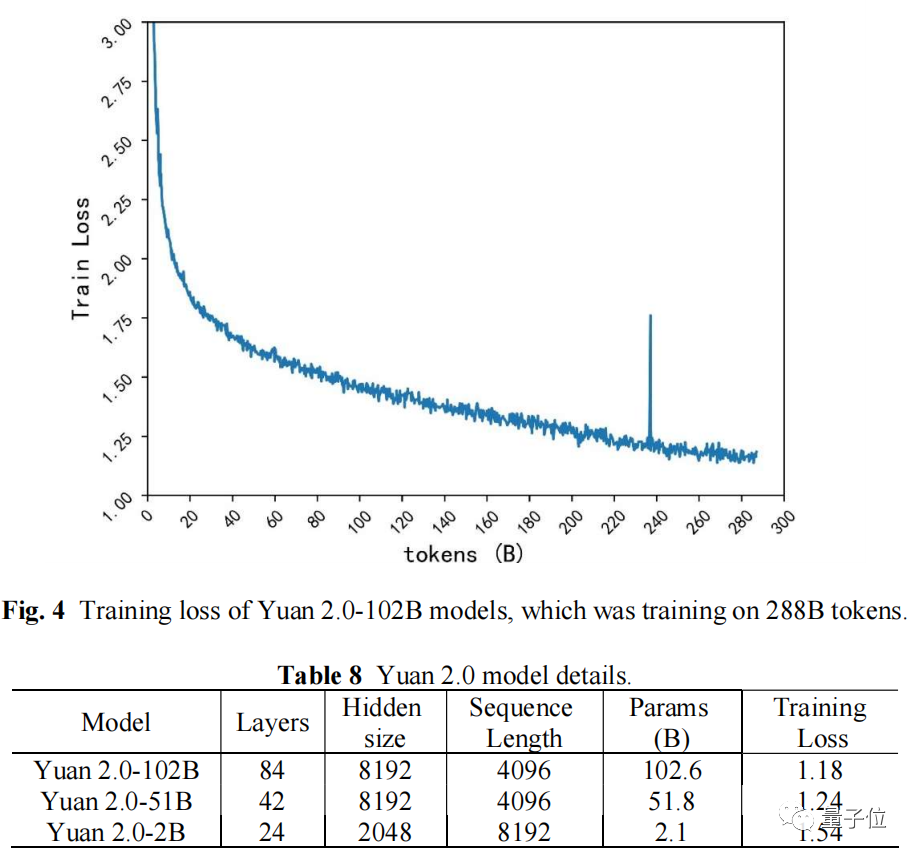

基於LFA的模型結構,源2.0-102B模型訓練288B的Tokens,最終Training Loss爲1.18;源1.0-245B模型訓練180B的Tokens,最終Training Loss爲1.64.從源1.0到源2.0,Training Loss降低28%。

03、計算的改進

相較於源1.0的計算方案,源2.0也進行了升級。

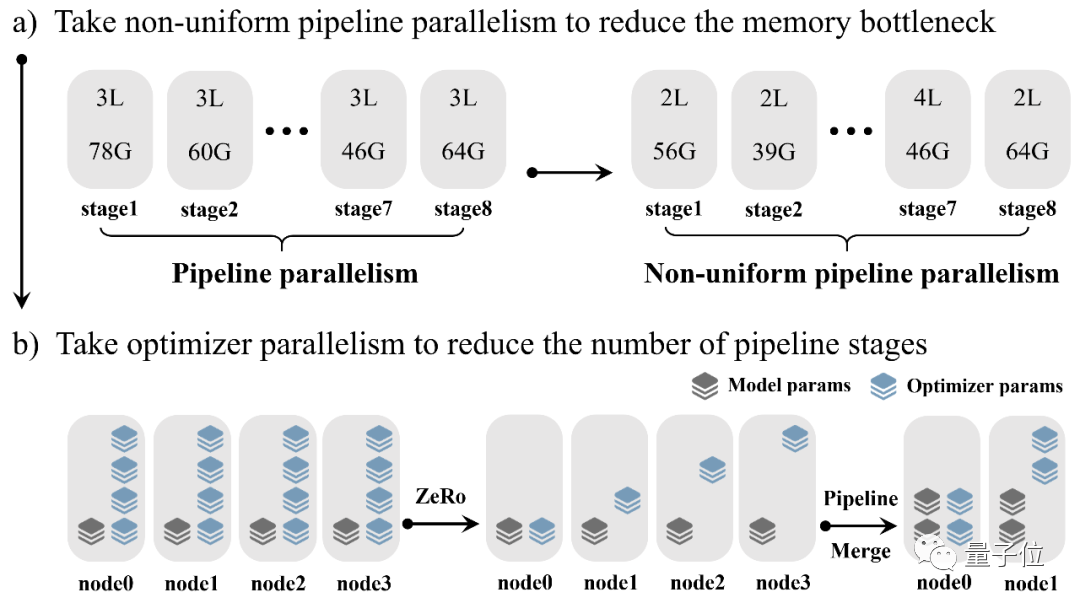

它在3D並行策略的基礎上,提出了

非均勻流水並行+優化器參數並行(ZeRO)+數據並行

的策略。

採用源2.0的分佈式訓練算法,

性能幾乎不隨帶寬變化

(0.4%),模型預測的源2.0模型每步計算總耗時與實測值的

相對誤差僅爲3%

。

而在經典3D並行中,當芯片之間連接的帶寬從400GB/s降低至100GB/s,性能會降低約85%。

具體方案中,非均勻流水並行,能有效環節流水線頭部與尾部的內存瓶頸。

優化器參數並行,能進一步降低流水線每個階段的參數量,通信複雜度與數據並行類似。

綜上,源2.0的面世還伴隨着算法、數據、計算三方面更底層的創新。

隨着源2.0的開源、論文上線,這些創新也能直接向整個社區輸出。

浪潮信息此次推出了

開源共訓計劃

。

爲了讓開源模型更符合開發者應用需求,這個計劃支持開發者提出自己的應用或場景需求,由浪潮信息來準備訓練數據並對源大模型進行增強訓練,訓練後的模型依舊在社區開源。

開發者提出的需求沒有具體格式要求,只要表達清楚應用場景、對大模型能力的需求以及1~2條示例即可。

不過一直以來,浪潮信息在行業內的角色定位都更偏向於算力基礎設施方。

自源1.0之後,此時浪潮信息的“新一輪大模型入世之道”劍指何方?而它爲什麼能帶來這些創新?

背後打造者

實際上,源2.0大模型是

浪潮信息AIGC整體規劃

的一部分。

作爲算力行業龍頭玩家,浪潮信息通過開放共享自身的算力平臺、技術、實踐經驗,構建算力基礎設施+算法基礎設施,從技術和基礎設施支撐方面,降低AI開發壁壘和門檻。

換言之,浪潮信息不僅提供大模型所需的算力資源,

更提供大模型開發應用的一系列服務

。

爲此浪潮信息持續佈局基礎算法、訓練加速、算力調度管理等方面。源2.0大模型的推出,正是整體戰略中的最新舉措。

2021年浪潮信息推出“源1.0”大模型,成爲國內最早佈局大模型的企業之一

。

“源1.0”是中文AI巨量模型,規模達2457億參數,一度問鼎全球最大單體大模型。

同時團隊還完成了5TB高質量中文數據集清洗工作,建立了完整的從公開數據爬取到數據清洗、格式轉化、數據質量評估的完整流程和工具鏈。

隨後,

“源1.0”落地南京智算中心,也成爲國內首個(城市級)開放提供領先的智能大模型服務

。

過去2年中,浪潮信息也不斷向行業輸出大模型開發應用的能力。

比如助力網易伏羲中文預訓練大模型“玉言”登頂中文語言理解權威測評基準CLUE分類任務榜單,並在多項任務上超過人類水平。

2022年底ChatGPT趨勢爆發,一時之間,百模興起。

大模型的算力需求成爲今年業內最熱門話題之一。

無論是想要煉成一個大模型、提升模型智能水平,還是擴大應用,

都和算力投入直接相關

,業內也一度興起了“囤算力”熱潮。

但擁有足夠算力只是第一步,怎麼用好纔是更關鍵的,也更困擾行業。

大模型訓練過程比傳統分佈式訓練更復雜,訓練週期長達數月,容易出現訓練中斷、集羣計算效率低、故障頻發且複雜等問題。

作爲算力行業龍頭玩家,浪潮信息在今年8月推出了

大模型智算軟件棧OGAI“元腦生智”

。

它能提供AI Infra能力,提供從集羣系統環境部署到算力調度保障和大模型開發管理的全棧全流程的軟件,從而大幅提升大模型算力效率。

AI Infra的本義是AI基礎設施,但目前業內更傾向於將其定義爲

軟件層面

。浪潮信息的OGAI(Open GenAI Infra)處於智算硬件之上、AI應用之下的軟件層,強調系統環境部署、算力調度保障、模型開發管理三方面能力。

OGAI由5層架構組成,從L0到L4分別對應於基礎設施層的智算中心OS產品、系統環境層的PODsys產品、調度平臺層的AIStation產品、模型工具層的YLink產品和多模納管層的MModel產品。

能實現自動化部署和彈性擴展,具備大模型斷點續訓能力,提供經過驗證的數據治理、大模型預訓練和微調開發工具,還能對多模型進行管理評估,加速模型部署和應用。

這些能力組合,可以解決最備受關注的三方面問題:

- 算力資源的高效性

:相同時間相同資源下更快完成訓練,或者相同時間內處理更多任務。 - 算力集羣的可擴展性

:隨着模型參數量、數據集擴大,對計算資源的需求增大,需要算力集羣可靈活擴展。但是由於並行計算必定會造成損耗,儘可能保持線性性能擴展,也是充分挖掘算力的一部分。 - 算力系統的可持續性

:大模型訓練中因爲故障出現訓練中斷,就需要從最新的Checkpoint重新載入繼續訓練。每一次中斷都需要花費時間修復,也會消耗資源,所以要儘可能提高算力系統的可持續性,提高效率降低成本。

在實際能力上,OGAI支持斷點續訓恢復、平均故障處理時間

小於5分鐘

;千億模型千卡集羣平均計算峯值效率

提升54%

;支持多元算力,

可穩定接入40+多元算力

。PODsys還是

業內首個開源

的AI算力集羣系統環境部署方案。

至此,浪潮信息不僅積累了大模型開發能力,還成功向行業輸出大模型訓練部署管理經驗,加速整個生成式AI浪潮的演進速度。

如今推出源2.0正是例證,它詮釋了“如何讓算力更好地匹配智能涌現”。

用最先進大模型作爲底座,從垂直場景針對性切入,構建技能模型、進而落地行業模型,也是當前業內已經確定的發展路徑,是走向AGI的必經之路。

顯然,源2.0發佈的意義,已經不侷限於“一個新模型誕生”。

源2.0意味着什麼?

對於浪潮信息自身而言,源2.0的推出意味着智算力的再次升級。

大模型趨勢的核心,還是要看最終能給產業帶來何種影響,即大模型的應用落地。

源1.0在To B領域的深度融合,已經驗證了路線的正確性。源2.0的推出,便是在此前基礎上進一步升級,之後可以提供更加滿足生成式AI趨勢的模型、算力、應用需求。

對於大模型趨勢而言,源2.0給行業增加了一個基座的選擇。

目前業內已經達成一個共識,在“百模大戰”初期,百花齊放是利好的。這能更大程度上釋放生產力,推動行業發展。

而且源2.0在算法、計算、數據上的創新,也向前推動了技術發展。

比如LFA的創新,給Transformer架構上限挖掘提出了一種參考;非均勻流水並行+優化器參數並行(ZeRO)+數據並行策略的提出,改進了源2.0的計算,也爲行業提出了緩解內存/計算瓶頸方案。

對於全行業而言,源2.0全面開源,讓生態更加繁榮。

優秀開源模型是吸引開發者、繁榮生態的關鍵因素,它能讓創新進行指數級增長,避免“重複造輪子”問題,加速創新迭代速度,給行業提供紮實底座和成長土壤。

最後,隨着源2.0的推出,浪潮信息的AIGC戰略版圖變得更加清晰,也向業內展示了從算力角度出發,可以爲行業提供怎樣的解決方案。

目前,國內“百模大戰”開始進入下半場。

後續還會有新模型入場,已發佈模型也在繼續不斷擴大規模,同時推理需求也開始加速增長。

整體市場的算力需求變得更加複雜多樣化。

在這樣的激烈變化之下,國產算力供應方還會向行業交出哪些答卷,值得關注。

如若转载,请注明出处:https://www.tuio.cc/370.html