分辨率達2560×2560

現在連文檔都有大模型了,還是高分辨率、多模態的那種!

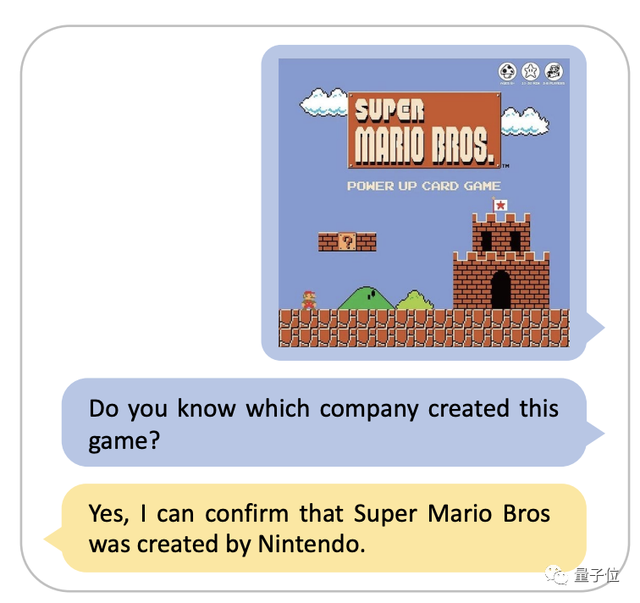

不僅能準確識別出圖像裏的信息,還能結合用戶需求調用自己的知識庫來回答問題。

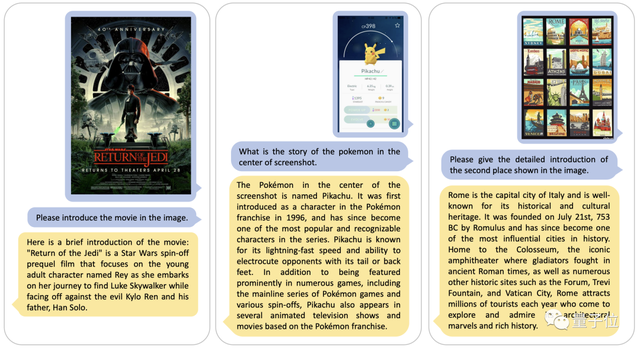

比如,看到圖中馬里奧的界面,直接就回答出了這是任天堂公司的作品。

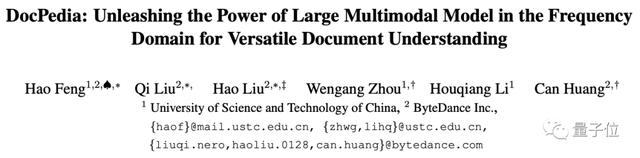

這款模型由字節跳動和中國科學技術大學合作研究,於2023年11月24日上傳至arXiv。

在此研究中,作者團隊提出DocPedia,一個統一的

高分辨率

多模態文檔大模型DocPedia。

在此研究中,作者用一種新的方式解決了現有模型不能解析高分辨文檔圖像的短板。

DocPedia分辨率可達2560×2560,而目前業內先進多模態大模型如LLaVA、MiniGPT-4等處理圖像分辨率上限爲336×336,無法解析高分辨率的文檔圖像。

那麼,這款模型究竟表現如何,又使用了怎樣的優化方式呢?

各項測評成績顯著提升

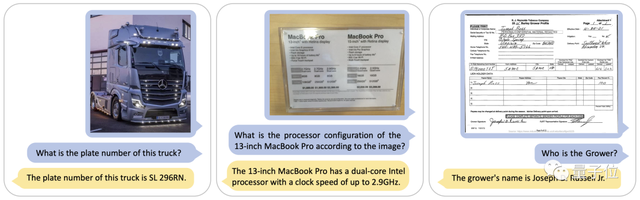

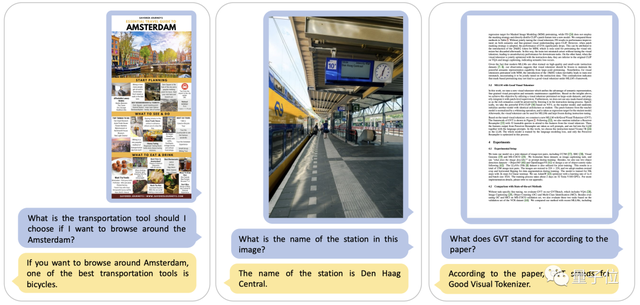

在論文中,作者展示了DocPedia高分辨圖文理解的示例,可以看到DocPedia能理解指令內容,準確地從高分辨率的文檔圖像和自然場景圖像中提取相關的圖文信息。

比如這組圖中,DocPedia輕鬆從圖片中挖掘出了車牌號、電腦配置等文本信息,甚至手寫文字也能準確判斷。

結合圖像中的文本信息,DocPedia還可以利用大模型推理能力,根據上下文分析問題。

讀取完圖片信息後,DocPedia還會根據其儲備的豐富的世界知識,回答圖像中沒有展示出來的擴展內容。

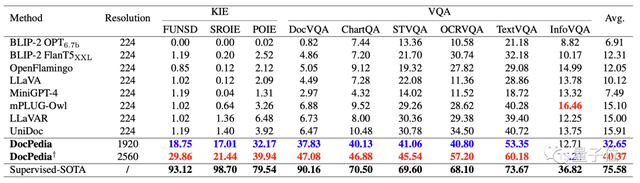

下表定量對比了現有的一些多模態大模型和DocPedia的關鍵信息抽取(KIE)和視覺問答(VQA)能力。

可以看到,分辨率的提升和有效的訓練方法使DocPedia在各項測試基準上均取得了不錯的提升。

那麼,DocPedia是如何實現這樣的效果的呢?

從頻域出發解決分辨率問題

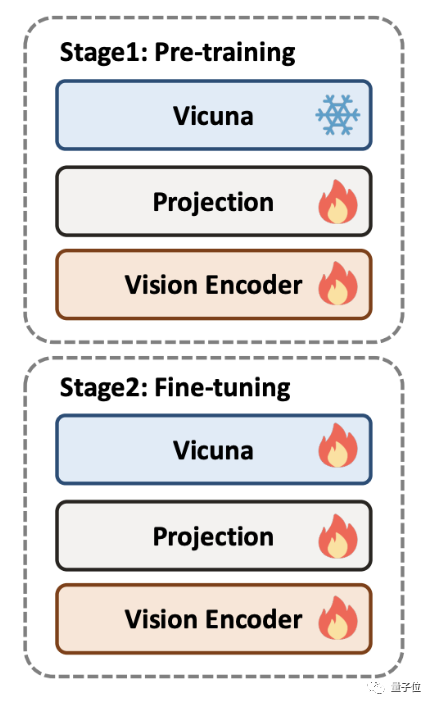

DocPedia的訓練分爲兩個階段:預訓練和微調。爲了訓練DocPedia,作者團隊收集了包含各類文檔的大量圖文數據,並構建指令微調數據集。

在預訓練階段,大語言模型被凍結,僅優化視覺編碼器部分,使其輸出token的表徵空間與大語言模型對齊。

在此階段,作者團隊提出主要訓練DocPedia的對感知能力,包括對文字和自然場景的感知。

預訓練任務包括文字檢測、文字識別、端到端OCR、段落閱讀、全文閱讀,以及圖像文字說明。

在微調階段,大語言模型解凍,整個模型端到端優化。

並且,作者團隊提出感知-理解聯合訓練策略:在原有低階感知任務的基礎上,增加文檔理解、場景圖像兩種高階的偏語義理解的任務。

這樣一種感知-理解聯合訓練策略,進一步提高了DocPedia的性能。

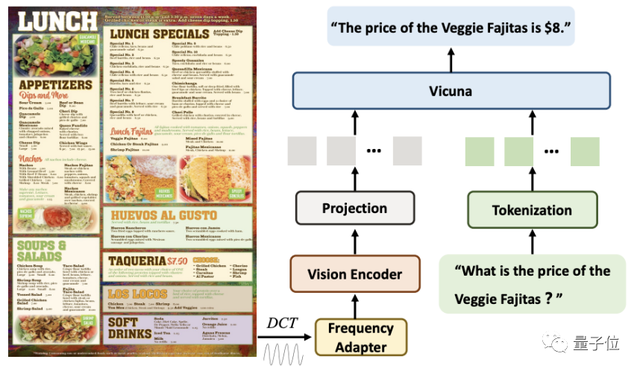

在分辨率問題的策略上,與現有方法不同,DocPedia從

頻域

的角度出發去解決。

給定一張高分辨率文檔圖像,DocPedia首先提取其DCT係數矩陣。該矩陣在不損失原圖像圖文信息的前提下,將其空間分辨率下采樣8倍。

然後,通過一個級聯的頻域適配器(Frequency Adapter),將其輸入視覺編碼器(Vision Encoder)進行進一步的分辨率壓縮和特徵提取。

通過此方法,一張2560×2560的圖像,其圖文信息可以用1600個token表示。

該方法相較於直接將原始圖像輸入到視覺編碼器(如Swin Transformer)中,token數量減少4倍。

最後,這些token與指令轉換而來的token進行序列維度拼接,輸入到大模型進行回答。

消融實驗結果表明,分辨率的提升和感知-理解聯合微調是DocPedia表現增強的兩大關鍵因素。

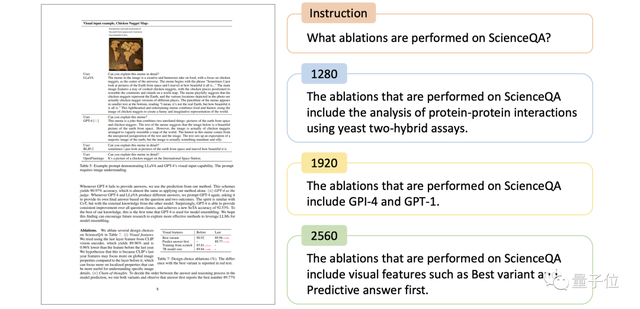

下圖對比了DocPedia對於一張論文圖像以及同一個指令,在不同輸入尺度下的回答。可以看到,當且僅當分辨率提升至2560×2560時,DocPedia回答正確。

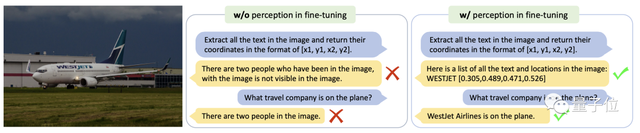

下圖則對比了DocPedia對於同一張場景文字圖像以及同一個指令,在不同微調策略下模型的回答。

由該示例可以看到,進行了感知-理解聯合微調的模型,能準確地進行文字識別和語義問答。

論文地址:https://arxiv.org/abs/2311.11810

如若转载,请注明出处:https://www.tuio.cc/486.html