一夜醒來,大型語言模型圈都在熱議一個詞-「GPU貧民」(GPU-Poor)。

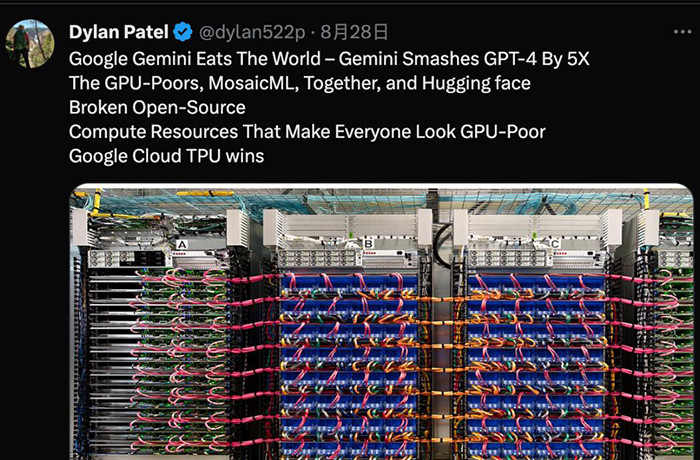

來自行業分析機構SemiAnalysis的一篇報告,爆料Google擁有的算力資源比OpenAI、Meta、亞馬遜、甲骨文和CoreWeave加起來還要多。

分析師Dylan Patel預測,Google DeepMind聯手的下一代大型語言模型Gemini,到年底訓練量將碾壓(Smash)GPT-4達到後者5倍。

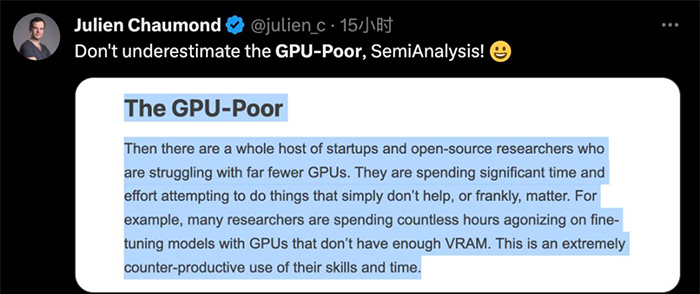

報告提出在這種壓倒性的優勢面前,大部分創業公司和開源勢力都成了「GPU貧民」,在用有限的資源苦苦掙扎。

這個說法迅速成為新梗,在相關產業裡流傳開來。

上次這麼紅的梗還是「沒有護城河」。巧了,也是同一位作者搞出來的,另外GPT-4內部架構細節大曝光也是他幹的。

被點名的開源扛把子HuggingFace聯合創始人Julien Chaumond表示:不要小看我們貧民啊!

也有人代表學生線上吐槽:金錢上窮,算力上也窮,說的就是我們博士生了。

正致力於讓手機跑大型語言模型的知名學者陳天奇表示,未來每個人都會擁有自己的AI助手,其中大多數人都會是「GPU貧民」,但不要低估合起來的總量。

也有不少人認為,拋開爭議性的內容和大部分內容收費不談,這篇報告的免費前言部分就是對大型語言模型行業現狀的一個很好的批評和總結。

「GPU貧民」面臨GPU不足,再怎麼努力都是虛功

報告下筆很不留情,直言很多創業公司在GPU匱乏情況下花費大量時間精力做的事,都是無用功。

比如很多人熱衷使用大型語言模型的輸出微調小模型,然後去刷排行榜,但是評估方法不完善,更注重風格而不是精準性或實用性。

報告還認為各種測量標準不完善的排行榜本身,也是對小公司的誤導,由此產生一大批不實用的模型,對開源運動也是一種傷害。

另一方面,GPU貧民們反而對資源的利用效率不高,大多使用密集模型,主要基於開放原始碼的羊駝生態。

但是OpenAI、Google這些巨頭已經在玩MoE架構這樣的稀疏模型,以及利用小模型投機採樣 (speculative decoding)提高推理效率了,完全是兩個遊戲。

作者希望GPU貧民們不應該過度限制模型規模以及過度量化,而忽視模型品質下降。應該專注於在共享的基礎設施上高效地提供微調模型,減少延遲和記憶體頻寬需求,滿足邊緣計算的需求。

看到這裡,也有人提出不同意見,認為創造性的突破往往正是來自有限制的環境,這反而是某種優勢。

但Perplexity.AI聯合創始人Aravind Srinivas認為,GPU豐富的組織實際也會投資於帶限制條件的研究。

並且要找到下一個像Transformer這樣的突破,需要成千上萬次的實驗,要求的資源絕對不低。

「GPU土豪」的遊戲怎麼玩

那麼GPU平民的另一面,Google這個「GPU土豪」在做什麼呢?

嚴格來說,Google算力不是GPU而是自家TPU。報告認為雖然TPUv5單體性能不如NVIDIAH100,但是Google有最高效的基礎設施架構。

Google大腦與DeepMind合併後,聯手訓練對準 GPT-4 的 Gemini 大型語言模型。

由前DeepMind兩位研究VP Koray Kavukcuoglu與Oriol Vinyals和前Google大腦掌門人Jeff Dean共同領導百人團隊。

根據多方爆料,Gemini預計年內就會發佈,更準確的來說是美國的秋季範圍之內(9月23日-12月21日)。

Gemini將整合大型語言模型與AI圖像生成的能力,使用Youtube上93.6億分鐘的視訊字幕訓練,總資料集大小據估計是GPT-4的兩倍。

前DeepMind創始人Hassabis曾透露,Gemini將結合AlphaGo類型系統的一些能力和“其他非常有趣的創新”。

另外Google創始人布林也一直在親自參與Gemini研發,包括對模型做評估並協助訓練。

關於Gemini更具體的消息還不多,但是有人推測也將與GPT-4一樣使用MoE架構和投機採樣技術。

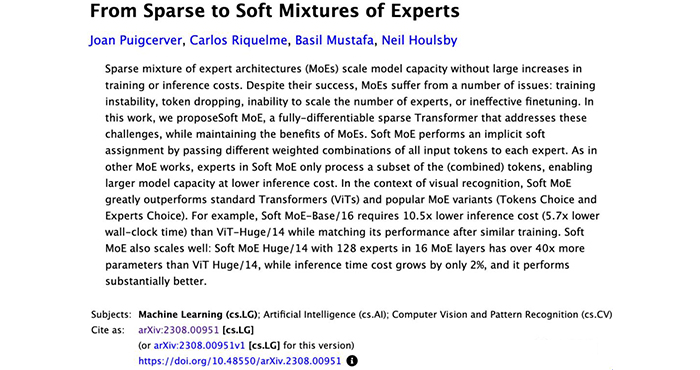

8月初Google DeepMind發表的新論文From Sparse to Soft Mixtures of Experts被認為可能與Gemini相關。

投機採樣能在不損失生成品質的前提下,讓Transformer大型語言模型獲得2-3倍的推理加速。

具體來說是讓小模型生成提前生成一些token並讓大型語言模型做評判,如果接受就讓大型語言模型生成下一個token再重複第一步,如果小模型生成的品質不高再換用大型語言模型。

Google一方的投機採樣論文在2022年11月才發表,但之前的爆料認為GPT-4也用了類似的技術。

實際上投機採樣技術的前身Blockwise Parallel Decoding也來自Google,作者中包括Transformer作者中的Noam Shazeer。

Noam Shazeer這個人在Google時同時參與了Transformer、MoE和投機採樣的研究,對今天的大型語言模型來說都至關重要,另外他還參與了T5、LaMDA和PaLM等多個大型語言模型研究。

SemiAnalysis的報告中還講了他的一個八卦。

早在GPT-2時代Noam Shazeer就在Google寫了一份內部備忘錄,預測了未來大型語言模型將以各種方式融入人們的生活,但當時這個觀點並未被Google重視。

現在看來,他預測的很多事都在ChatGPT發佈後真實發生了。

不過Noam Shazeer在2021年就離開Google創辦了Character.ai,按照這篇報告的說法,他現在也是「GPU貧民」的一份子。

新聞轉載自:量子位

如若转载,请注明出处:https://www.tuio.cc/514.html