夢晨 發自 凹非寺

量子位 | 公衆號 QbitAI

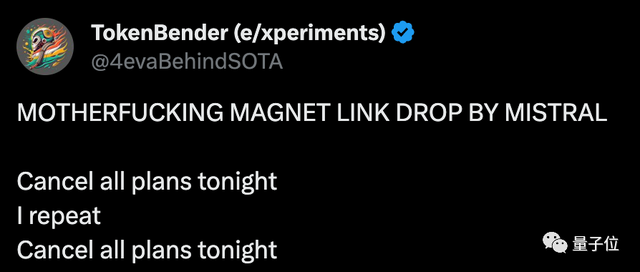

“取消今晚所有計劃!”,許多AI開發者決定不睡了。

只因

首個開源MoE大模型

剛剛由

西北風AI

發佈。

MoE架構全稱

專家混合

(Mixture-of-Experts),也就是傳聞中

GPT-4採用的方案

,可以說這是開源大模型離GPT-4最近的一集了。

沒有發佈會、沒有宣傳視頻,只靠一個磁力鏈接,就產生如此轟動效果。

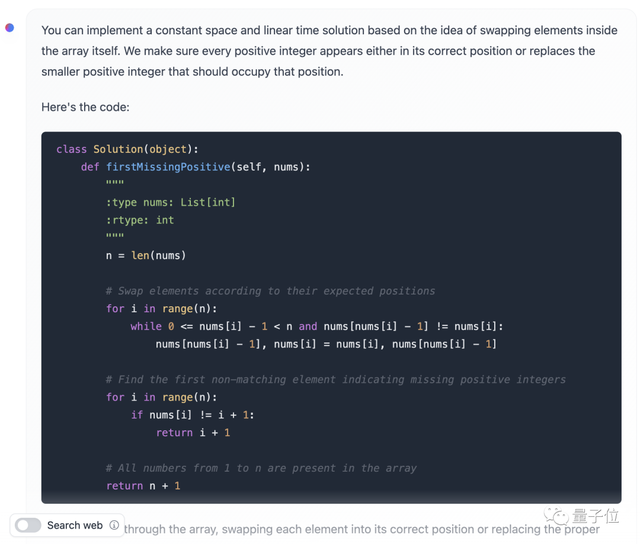

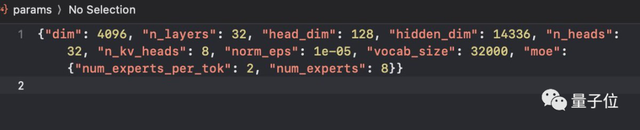

具體參數還得是網速快的人下載完之後,從配置文件裏截圖發出來的:

7B參數x8個專家

,對每個token選擇前兩個最相關的專家來處理。

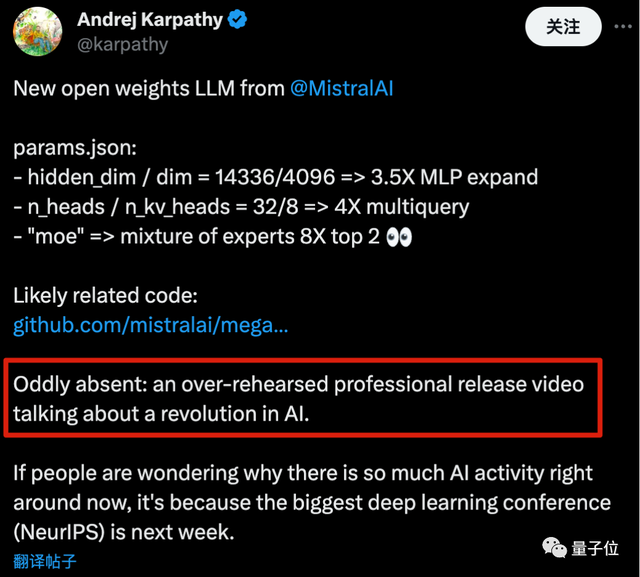

以至於OpenAI創始成員Karpathy都吐槽,是不是少了點什麼?

怎麼缺了一個那種排練很多次的專業範視頻,大談特談AI變革啊。

至於吐槽的是誰,懂得都懂了。

以及他還解釋了爲什麼AI社區這幾天如此活躍:最大的深度學習會議NeurIPS即將在下週開啓。

MoE,開源大模型新階段?

爲何這款開源MoE模型如此受關注?

因爲其前身

Mistral-7B

本來就是開源基礎模型裏最強的那一檔,經常可以越級挑戰13B、34B。

並且Mistral-7B以寬鬆的

apache - 2.0

開源協議

發佈,可免費商用,這次新模型很可能沿用這個協議。

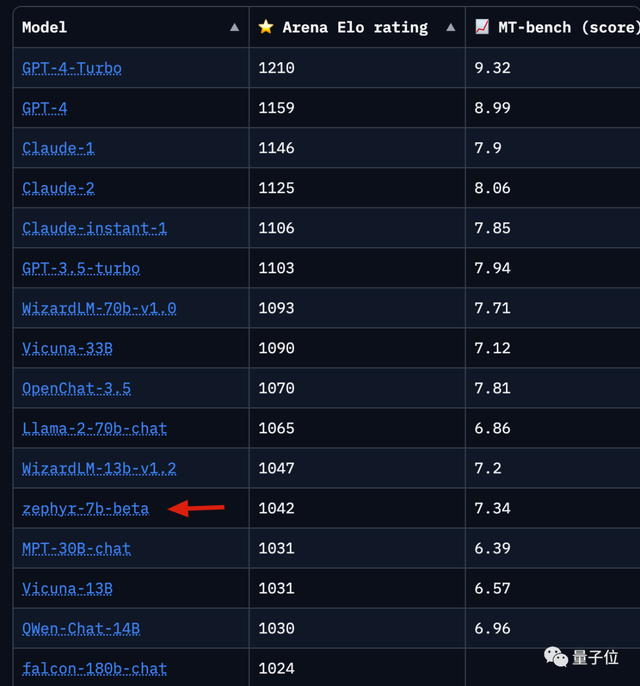

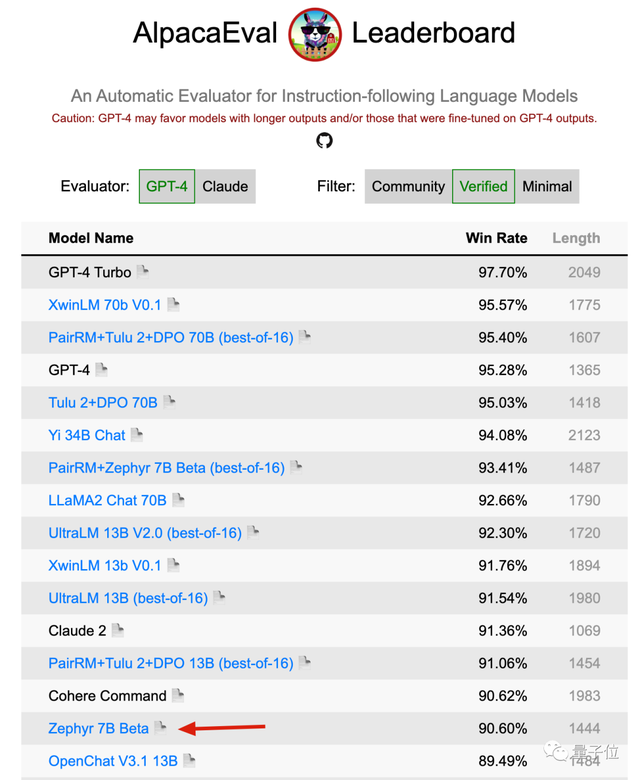

在多個評測排行榜上,基於Mistral-7B微調的Zephyr-7B-beta都是

前排唯一的7B模型

,前後都是規模比他大得多的模型。

LLMSYS Chatbot Arena上,Zephry-7B-beta目前排

第12

。

AlpacaEval上,也排到

第15

。

目前這個新的MoE模型連個正式名字都還沒有,社區一般稱呼它

爲Mistral-7Bx8 MoE

。

但在大家期待的期待中,新MoE模型對比單體Mistral-7B的提升幅度,就應該像GPT-4對比GPT-3.5那樣。

但是注意了,有人提醒大家MoE對於本地運行來說不是太友好,因爲更佔內存

但更適合部署在雲端,跨設備專家並行,給公司處理併發需求帶來成本優勢。

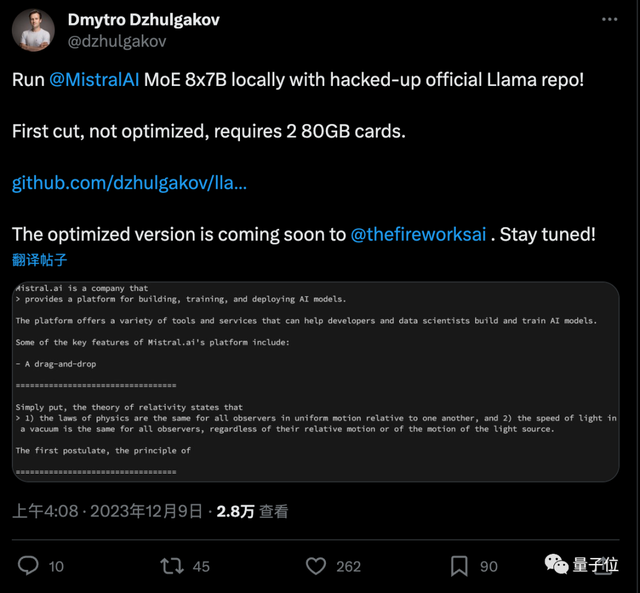

行動比較快的公司是前PyTorch成員出走創辦的

fireworks.ai

。

第一次嘗試、沒有任何優化的情況下,需要兩張80GB內存的卡,優化版本即將推出。

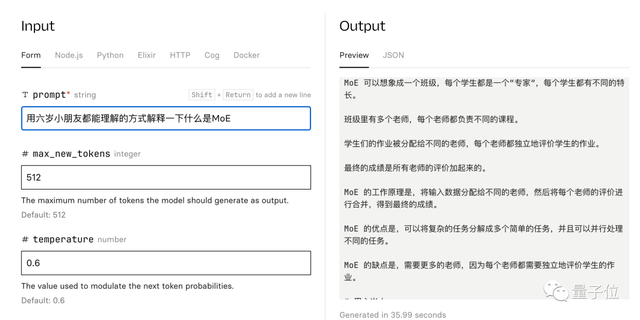

Replicate上也有了可試玩版本,簡單試用發現中文水平也不錯。

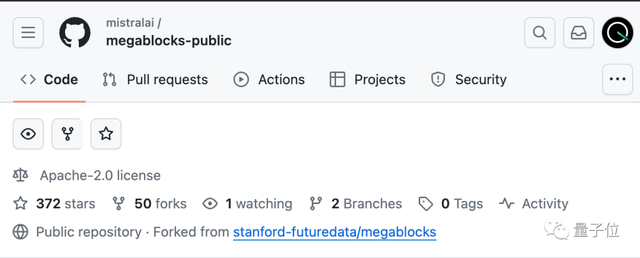

其實Mistral AI也爲大家準備了官方配套代碼,使用了斯坦福去年發佈的輕量級MoE庫Megablocks。

創始人:小模型支持更多有意思的應用

Mistral AI由前DeepMind、前Meta科學家創辦。

剛剛完成一輪4.87億美元的新融資,最新估值逼近

20億美元

,已晉升獨角獸。

三位聯合創始人中,CEO

亞瑟·門施

此前在DeepMind巴黎工作。

CTO

蒂莫西·拉克魯瓦

和首席科學家

Guillaume Lample

則在Meta共同參與過Llama系列的研發,Lample是通訊作者之一。

Arthur Mensch曾在接受採訪時談到,讓模型變小是支持Agent發展的路徑之一。

如果能把計算成本降低100倍,就能構建起更多有意思的應用。

Mistral AI成立於今年5月,種子輪融資1.13億美元。

9月底,Mistral AI以磁力鏈接的形式發佈第一個開源模型Mistral-7B,當時很多開發者試用後都覺得Llama-2不香了。

12月初,Mistral AI再次甩出開源MoE模型磁力鏈接,再次掀起一波熱潮。

這就是公司官號僅有的幾次發言。

不少人都拿來和最近谷歌的過度宣傳做對比。

最新的梗圖:磁力鏈接就是新的arXiv。

參考鏈接:

[1]https://x.com/MistralAI/status/1733150512395038967?s=20

[2]https://github.com/mistralai/megablocks-public

[3]https://replicate.com/nateraw/mixtral-8x7b-32kseqlen

如若转载,请注明出处:https://www.tuio.cc/1226.html